¿Cuáles son las contribuciones al conocimiento realizadas por los ganadores de premios que, a lo largo de más de un siglo, se convirtieron en uno de los mejores mecanismos del mundo para identificar avances cruciales de las ciencias?

FISIOLOGÍA O MEDICINA

Virus de hepatitis C: hitos y desafíos en cincuenta años de historia

Este año, el premio Nobel de fisiología o medicina fue otorgado por partes iguales a los estadounidenses Harvey J Alter (US National Institutes of Health) y Charles M Rice (Rockefeller University) y al británico Michael Houghton (University of Alberta) por el descubrimiento del virus de Hepatitis C.

La infección por hepatitis C es una de las principales causas de enfermedad hepática crónica. Se estima que más del 1% de la población mundial está infectada y que el 80% desarrolla una forma crónica de enfermedad hepática de evolución lenta y asintomática caracterizada por daño celular, inflamación y fibrosis que puede progresar, luego de algunas décadas, a cirrosis en el 30-40% de los casos o a carcinoma hepático en el 1-3%. De esta forma la infección por este virus es una de las causas más frecuentes de trasplante hepático. Ante la falta de una vacuna, el enfoque terapéutico recorrió diferentes etapas, desde los tratamientos prolongados con moduladores del sistema inmunitario con tasas de curación de menos del 50% y elevados efectos adversos, pasando por generaciones sucesivas de antivirales de acción directa, hasta llegar al presente con una nueva generación de antivirales, con tasas de curación del 95% al 100% después de solo ocho a doce semanas de una terapia oral no tóxica.

La historia de este virus es una saga de 45 años iniciada con las observaciones de Harvey J Alter en 1975, quien demuestra la existencia de un virus de hepatitis no-A no-B asociado a hepatitis postransfusional. Continúa con los trabajos de Michael Houghton, en 1989, quien logra clonar e identificar el genoma viral y renombrarlo como virus de hepatitis C. Más tarde los experimentos de Charles Rice, en la década de 1990, establecen, a partir de una versión editada del genoma del virus, un sistema robusto de replicación in vitro en cultivos celulares, y sientan así las bases para futuros análisis genéticos y funcionales. Estos descubrimientos posibilitaron finalmente el diagnóstico de la infección, el control y la prevención en algunos grupos de riesgo y el desarrollo de nuevos medicamentos que han salvado millones de vidas.

Se sabe que las infecciones virales son una de las principales causas de hepatitis, es decir, de inflamación del hígado. Ya en la década de 1940 se conocían dos tipos de hepatitis infecciosa: la llamada hepatitis A que se transmitía por contaminación de agua o alimentos y generalmente tenía poco impacto a largo plazo en el paciente, y un segundo tipo que se transmitía a través de sangre y fluidos corporales que representaba una amenaza mucho más grave. Sin embargo, la clave para una intervención exitosa contra las enfermedades infecciosas es identificar el agente causal. En este camino, en la década de 1960 Baruch Blumberg identificó una forma de hepatitis transmitida por la sangre que se conoció como virus de la hepatitis B, descubrimiento que permitió el desarrollo de pruebas de diagnóstico y posteriormente de una vacuna eficaz. Blumberg fue galardonado en 1976 con el premio Nobel en fisiología o medicina por este logro. En ese momento, Harvey J Alter y otros colegas observaron que, a pesar de la disminución de individuos con hepatitis postransfusionales como consecuencia de la detección del virus de hepatitis B, había aún un número preocupante de casos probablemente debido a otra etiología viral. El equipo liderado por Alter inoculó a cinco chimpancés con sueros de pacientes que habían desarrollado hepatitis postransfusionales. En este experimento se observó que todos los animales inoculados presentaban síntomas, concluyendo que la sangre de los pacientes con hepatitis no-A no-B podría transmitir la enfermedad a los chimpancés, quienes resultaron ser los únicos huéspedes susceptibles, además de los humanos. Este resultado sugería la idea de un agente, probablemente un virus, transmisible. Estudios posteriores de Daniel W Bradley (US National Institutes of Health) y Robert Purcell (US Center for Disease Control) demostraron que dicho agente se podía inactivar con solventes orgánicos y que era filtrable a través de un poro de 50 nanómetros, lo cual indicaba que se trataba de un agente infeccioso con las características de un virus pequeño y envuelto en una membrana lipídica. De esta manera se describió una nueva forma de hepatitis viral crónica en pacientes que progresaban lentamente a cirrosis hepática, que se conoció como hepatitis NANB.

La identificación de este nuevo agente infeccioso se volvió prioritario y, si bien se pusieron en práctica todas las técnicas tradicionales, el virus eludió el aislamiento durante más de una década. Fue entonces cuando Michael Houghton en 1982, en los laboratorios de la empresa biotecnológica Chiron, iniciara en forma silenciosa y tenaz los experimentos de clonación de ácidos nucleicos obtenidos a partir de plasma de humanos y chimpancés infectados con hepatitis NANB. La estrategia exitosa se basó en la generación de una biblioteca de expresión recombinante derivada de plasma de chimpancés infectados. Esto implicó aislar las moléculas de ARN presentes en el plasma infectado y copiarlas a moléculas de ADN para luego, utilizando vectores virales, insertarlas al azar en una población de bacterias Escherichia coli. Así, cada colonia o clon de bacterias provenientes de cada evento de trasformación con ese ADN produciría las proteínas codificadas por los genes virales. Utilizando los anticuerpos presentes en sueros de individuos con hepatitis NANB crónica o pacientes recuperados espontáneamente se podría identificar a las colonias que produjeran o expresaran proteínas virales.

Fue entonces cuando, luego de casi seis años de experimentos fallidos, lograron identificar un único clon reactivo que fue el puntapié inicial para secuenciar el genoma completo de este pequeño virus perteneciente a la familia Flaviviridae, renombrado como virus de la hepatitis C.

El descubrimiento del virus fue decisivo. Sin embargo, uno de los principales dilemas que ocuparon a los investigadores durante la década de 1990 fue la imposibilidad de infectar eficientemente sistemas de células en cultivo in vitro a partir de aislamientos de pacientes con hepatitis C. Es así como Charles Rice observó variaciones genéticas en aislamientos virales e identificó, en un extremo del genoma del virus de la hepatitis C, una región importante para su replicación. Así se generó una versión editada del genoma del virus que replicaba y producía las proteínas virales. Desde entonces, el advenimiento del replicón y, posteriormente, de los sistemas de cultivo celular exitosos para el virus de la hepatitis C abrieron una ventana de oportunidades para la investigación básica del virus que permitió caracterizar detalladamente el ciclo de replicación viral y los factores del hospedador relacionados para la infección. Sin embargo, el mayor impacto de las investigaciones de Charles Rice fue proporcionar una plataforma para el diseño y la prueba de potenciales antivirales dirigidos contra las proteínas del virus.

Los avances terapéuticos recientes han sido tan notables que ahora es posible especular que la infección por el virus de la hepatitis C podría erradicarse globalmente, incluso en ausencia de una vacuna. En este sentido, en 2016 la Asamblea Mundial de la Salud aprobó una estrategia global para alcanzar la eliminación de las hepatitis virales (C y B) para 2030 que tiene como objetivo reducir la incidencia y mortalidad de pacientes de hepatitis C y alcanzar con tratamiento a por lo menos el 80% de aquellos infectados. Sin embargo, existen varios obstáculos que deben sortearse para alcanzar este objetivo. Por un lado, es de fundamental importancia que cada país conozca la epidemiología de la infección mediante la implementación de programas sistemáticos y organizados de detección de portadores silenciosos. Por otro lado, es necesario asegurar el acceso al tratamiento a todas las personas infectadas, lo cual es difícil por el elevado costo. Finalmente, es fundamental realizar tareas de prevención primaria para evitar la generación de nuevos casos y la reinfección de pacientes ya curados, en especial en los grupos de mayor riesgo.

A pesar de los muchos desafíos futuros, esta historia nos muestra cuán lejos la ciencia ha llegado en solo cincuenta años. Estos avances se deben al gran esfuerzo, dedicación y compromiso que han demostrado Harvey J Alter, Michael Houghton, Charles M Rice y todos sus colaboradores, y de tantos otros científicos que trabajan para mejorar la calidad de vida, curar y prevenir la infección por el virus de la hepatitis C.

Lecturas sugeridas

Alter HJ, 2019, ‘The Gordon Wilson Lecture: The Hepatitis C Virus: From Hippocrates to Cure’, Transactions of the American Clinical and Climatological Association, 130:104-118.

Houghton M, 2009, ‘The long and winding road leading to the identification of the hepatitis C virus’, Journal of Hepatology, 51(5): 939-948.

Luna JM, Saeed M, Rice CM, 2019, ‘Taming a beast: lessons from the domestication of hepatitis C virus’, Current Opinion in Virology, 35: 27-34.

María Victoria Preciado y Pamela Valva

Instituto Multidisciplinario de Investigaciones en Patologías Pediátricas (IMIPP- Conicet-GCBA), División Patología, Hospital de Niños Ricardo Gutiérrez

ECONOMÍA

Subastas: teoría y práctica

El premio Banco de Suecia en ciencias económicas en memoria de Alfred Nobel fue otorgado este año a Paul Milgrom y Robert Wilson, de la Universidad Stanford. La Academia Sueca, en su descripción de los méritos principales de los galardonados, resaltó sus aportes a la teoría de subastas y a la creación y utilización en la práctica de nuevos diseños y reglas de subastas.

Las subastas son mecanismos a través de los cuales se asigna un conjunto de bienes, servicios, contratos o derechos haciendo que los interesados en recibirlos compitan realizando ofertas, generalmente monetarias. Esencialmente, se trata de procesos para ‘descubrir’ precios. Existe evidencia histórica de ventas mediante remates al menos desde la antigua Babilonia, como nos hace saber el historiador griego Heródoto.

Actualmente se emplean en múltiples ámbitos, desde la asignación de espectro para comunicaciones personales –una aplicación especialmente relevante para este premio Nobel– hasta las contrataciones públicas o la compra de electricidad a generadores; desde la venta de permisos de emisión de gases contaminantes hasta la asignación de posiciones para las publicidades en pantalla cada vez que un usuario realiza una búsqueda en Google. El grado de eficiencia de muchos mercados y su capacidad de contribuir al bienestar de consumidores y usuarios depende en buena medida de que se utilice la subasta correcta. Entender el desempeño de estos mecanismos y cuáles son las subastas adecuadas para cada aplicación, entonces, es un problema económico crucial.

Los formatos de subasta posibles son muy variados. Tomemos un caso muy simple: se debe vender un objeto único e indivisible; por ejemplo, una obra de arte o una licencia única para operar en un mercado. Puede realizarse una subasta abierta o cerrada. En el primer caso, los postores anuncian sus ofertas públicamente. Hay dos formatos clásicos en esta categoría. Por un lado, la subasta inglesa, en la que los postores pujan públicamente subiendo ofertas hasta que nadie esté en condiciones de superar la oferta vigente. Existe también la llamada subasta holandesa, o de precio descendente, donde se parte de un precio inicial alto que desciende progresivamente hasta que uno de los postores detenga su caída y adquiera el bien en cuestión. En una subasta cerrada, en cambio, los postores comunican sus ofertas al subastador de modo secreto. El formato más usual es la subasta de primer precio, donde gana quien hizo la oferta más alta y paga su oferta. En la subasta de segundo precio, en cambio, también gana el mejor postor, pero paga la segunda mayor oferta.

Muchos otros formatos pueden emplearse o crearse, incluso en este caso sencillo. Uno de los objetivos centrales de la teoría de subastas es identificar los resultados de cada formato en cada caso. Por ejemplo, el análisis teórico básico permitió concluir que la subasta holandesa y la de primer precio siempre son equivalentes (es decir, generan el mismo resultado y benefician igualmente a todos los participantes), mientras que la subasta inglesa y la de segundo precio lo son en algunos contextos.

Definidas las reglas y dadas las características de los participantes, cada subasta genera un juego. Allí, la teoría de juegos permite predecir el comportamiento de los postores y anticipar el resultado. Es posible, entonces, realizar comparaciones. Dados dos formatos, ¿cuál será ‘mejor’? Dos criterios habituales para realizar la comparación son (i) ingreso esperado del vendedor y (ii) eficiencia en la asignación –es decir, el valor creado para la sociedad por el hecho de que el objeto termine en quien lo reciba–. Pero la teoría también permite ser más ambiciosos. Considerando lo que se vende o se compra, y dadas las características de los postores, ¿cuál sería ‘el mejor’ formato de subasta en función del criterio de interés (ingreso esperado o eficiencia)?

Un modo breve de describir los resultados a los que la teoría ha llegado es que los detalles importan. No existe una única subasta adecuada para todos los casos. El trabajo pionero de Milgrom y Wilson permite entender en profundidad qué es lo importante en cada contexto, y es crucial para permitir que la teoría genere más y mejores aplicaciones.

Pensemos, por ejemplo, en cómo los oferentes forman su valoración por un objeto en venta. En un extremo, sus valoraciones son privadas: cuánto vale el objeto para un postor es completamente idiosincrásico, sin relación con cuánto lo valoran los demás, como ocurre con objetos de consumo personal. En el extremo opuesto, las valoraciones son comunes: imaginemos que se subasta el derecho a explotar un campo petrolífero. Si las empresas interesadas cuentan con la misma tecnología, el derecho tendrá el mismo valor para todas, dado que obtendrán el mismo volumen de petróleo. Sin embargo, dicho volumen es incierto. En la subasta, quienes cuenten con estimaciones más optimistas serán más agresivos, por lo que ganará el postor con la estimación más alta. La máxima estimación es muy probablemente una sobreestimación. Este fenómeno, conocido como maldición del ganador, fue formalmente analizado por Wilson. Naturalmente, los postores deberían anticiparlo y realizar ofertas más conservadoras. El formato de subasta afecta cuánto menos deberían pujar.

En la mayoría de los contextos usuales, las valoraciones de los postores tienen elementos privados y comunes. Estos casos intermedios son analíticamente más complejos, y es aquí donde aparece una de las contribuciones centrales de Milgrom a la teoría. En un par de artículos, uno de ellos en coautoría con Robert Weber, Milgrom planteó un modelo que permite analizar todos los casos de valoraciones interdependientes, incluyendo los extremos de valoraciones privadas y comunes como casos particulares. Introdujo el concepto de valoraciones afiliadas, una forma especial de correlación, que permitió identificar los resultados de los formatos usuales de subasta y compararlos. Ello hizo posible derivar conclusiones vitales a la hora de elegir y diseñar subastas. Comprobó, por ejemplo, que aquellos formatos que permiten a los postores agregar mejor la información dispersa entre ellos (tales como la subasta inglesa) generarán más ingreso esperado para el vendedor.

Todos los ejemplos mencionados corresponden al caso de compra o venta de un único objeto indivisible, el más simple. En muchas situaciones, sin embargo, el objeto a asignar es divisible y su cantidad puede no estar fija, como ocurre con los activos financieros o con la compra de electricidad a generadores. En otros casos, deben asignarse objetos múltiples indivisibles, como en las licitaciones de licencias de espectro. Si se subastan objetos múltiples, el formato debe especificar si se asignan todos a la vez o en orden sucesivo, si los postores que compran bienes iguales pagan el mismo precio o el precio que cada uno ofreció, si la subasta procede en rondas o en una sola etapa, si las ofertas son públicas o privadas, etcétera. Las dimensiones del problema aumentan considerablemente.

Si se asigna un objeto divisible, los postores pueden desear recibir una cantidad decreciente en el precio. Así, en las subastas de bonos los postores pueden ofrecer demandas –funciones que especifican la cantidad deseada para cada precio– y en una licitación de electricidad los generadores pueden competir emitiendo funciones de oferta. Algunas de las principales contribuciones de Wilson corresponden a los casos de activos financieros y electricidad, y el desempeño de cada subasta en cada contexto específico relevante en dichos mercados.

Las subastas de objetos múltiples e indivisibles introducen nuevos aspectos. Los postores pueden desear recibir uno o más objetos, y las diferentes unidades, especialmente cuando son heterogéneas entre sí, pueden ser percibidas como complementarias o sustitutivas. Por ejemplo, en una licitación de espectro, se asignan licencias para usar ciertos segmentos de frecuencias, potencialmente en diferentes regiones geográficas de un país. Para un operador de telefonía celular, cierta porción del espectro puede no tener valor por sí sola, pero sí cuando se la combina con otra porción.

A comienzos de la década de 1990, la Federal Communications Commission (FCC) de los Estados Unidos decidió explorar el uso de subastas para asignar espectro ante la creciente importancia de la telefonía móvil. La teoría de subastas desarrollada hasta entonces no brindaba una recomendación definitiva. Paul Milgrom, Robert Wilson y R Preston McAfee propusieron el uso de subastas simultáneas en rondas múltiples. En dicho formato, todas las licencias se asignaban al mismo tiempo. En cada ronda, un postor podía pujar por una o varias licencias, derrotando al precio vigente en cada una, al estilo de la subasta inglesa. Con algunas reglas técnicas adicionales, esto permitía a cada oferente saber qué licencias estaba ganando y cuáles no, y generaba más agresividad, dado que los oferentes inferían del comportamiento de sus rivales cuánto valoraban ellos cada licencia, reduciendo la maldición del ganador. Su empleo por parte de la FCC fue un éxito rotundo, tanto en la recaudación para el erario público como en su influencia sobre el funcionamiento del mercado, y se convirtió en el formato estándar empleado internacionalmente.

Sin embargo, los oferentes se exponían a un alto riesgo respecto del conjunto de licencias que ganarían. Si una empresa pujaba por dos licencias que no tenían valor individual, pero sí en conjunto, era posible que al final perdiera una de ellas y debiera adquirir la otra. Para evitar este problema, Milgrom, junto con otros economistas, desarrolló una subasta combinatoria, que permitía a los postores hacer ofertas por ‘paquetes’ de licencias. El nuevo formato se empleó por primera vez en el Reino Unido en 2008, y una vez más su éxito llevó a su adopción en numerosos países.

Los nuevos desarrollos han sido continuos. Con la participación prominente de Milgrom, la FCC realizó en 2017 un proceso complejo de subastas para reasignar espectro de sus licenciatarios hasta entonces (empresas de televisión) a nuevos licenciatarios, para su uso en comunicaciones personales. Esta complementación entre teoría y práctica en subastas ha permitido profundizar la comprensión de los procesos de asignación y un mejor funcionamiento de mercados de suma importancia, como los de energía y telecomunicaciones. A partir de estas experiencias en subastas, junto con otras áreas cercanas, ha surgido dentro de la economía una nueva especialidad, conocida como diseño de mercados.

Tanto Milgrom como Wilson realizaron aportes sustanciales fuera de la teoría y la práctica de subastas. No hay espacio para describirlas aquí, pero basta mencionar algunas áreas en las que sus contribuciones han sido altamente influyentes: la economía de la información, la teoría de incentivos y contratos, la economía financiera, la teoría microeconómica y la teoría de juegos en general.

Es destacable un hecho muy especial. Wilson no solamente recibió el premio Nobel, sino que también dirigió la tesis de otros dos ganadores –además de Milgrom–: Alvin Roth y Bengt Holmström (en 2012 y 2016 respectivamente). Esto evidencia la influencia profunda de Wilson y sus dirigidos en el análisis económico en las últimas décadas.

Finalmente, este premio provee una prueba adicional del impacto fundamental que ha tenido la introducción y el desarrollo de la teoría de juegos sobre la disciplina. Desde 1994, en al menos nueve años la Academia Sueca ha otorgado el premio por contribuciones a esta teoría, o por aportes obtenidos mediante su aplicación directa.

Lectura sugerida

Real Academia Sueca de Ciencias, “Improvements to auction theory and inventions of new auction formats,” Scientific Background on the Sveriges Riksbank Prize in Economic Sciences in Memory of Alfred Nobel 2020, accesible en www.nobelprize.org

Leandro Arozamena y Federico Weinschelbaum

Universidad Torcuato Di Tella

QUIMICA

Una ‘navaja suiza’ para la edición génica

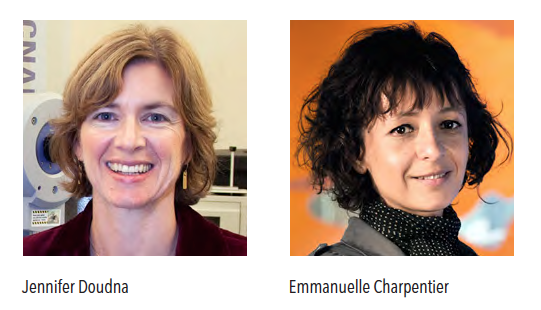

Sabíamos que sucedería: CRISPR iba a recibir un Nobel. A pesar de su corta edad, su importancia es indiscutible. La única duda era saber cuándo y quién lo recibiría, y la incógnita se develó el pasado 7 de octubre: el premio Nobel de química 2020 fue entregado a la estadounidense Jennifer Doudna (Universidad de Berkeley, California) y a la francesa Emmanuelle Charpentier (Instituto Max Planck, Berlín) por el desarrollo de la maquinaria programable de edición de genes más simple y efectiva que conocemos: el sistema binario de ARN y proteína, CRISPR-Cas. A través de millones de generaciones de evolución bacteriana se seleccionó el sistema de defensa molecular más simple jamás diseñado. La ciencia descifró los mecanismos más íntimos de este sistema en poco más de una década y, a partir de esto, comenzó a utilizarlo a su favor.

El nombre CRISPR, su caracterización y posible función biológica no se la debemos a las galardonadas, sino al microbiólogo español Francisco Mojica, quien con su grupo de la Universidad de Alicante analizó por más de diez años las enigmáticas secuencias repetitivas del genoma en unas bacterias de su vecina localidad de Santa Pola. Fue él quien escogió el acrónimo CRISPR (del inglés Clustered Regularly Interspaced Short Palindromic Repeats), que en castellano se traduce como repeticiones palindrómicas cortas agrupadas y regularmente interespaciadas.

Mojica estudió el ADN de estas bacterias y detectó secuencias repetitivas palindrómicas, que eran seguidas por otras secuencias denominadas ‘ADN espaciador’ muy similares a secuencias de virus y ADN de otras bacterias. El español hipotetizó que estas secuencias eran los restos de ADN incorporado al genoma bacteriano como consecuencia de una infección anterior y que la bacteria las usaba como una especie de memoria defensiva. Por esto, se trataría del sistema inmune más simple de la naturaleza, una memoria molecular para evitar la siguiente infección con este ADN foráneo.

Irónicamente, el trabajo de Mojica fue rechazado en Nature, una de las revistas más prestigiosas del mundo científico, y publicado luego en una revista de menor impacto. Sin embargo, la propuesta era tan relevante que otros investigadores de Europa y Estados Unidos se lanzaron a la carrera de comprender los detalles genéticos, bioquímicos y moleculares de este curioso sistema defensivo.

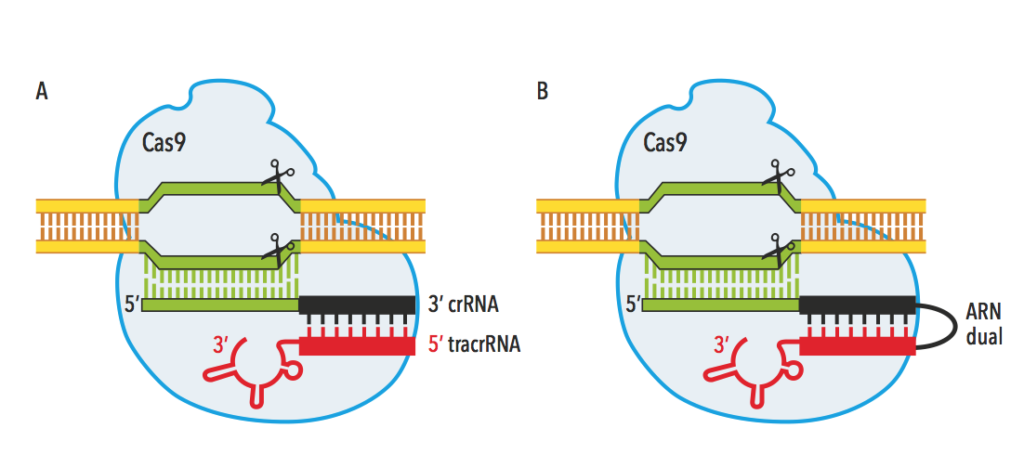

Hoy sabemos que CRISPR está presente en los genomas de una amplísima diversidad de organismos procariotas (microorganismos de los dominios Eubacteria y Arquea). Con la capacidad de incorporar segmentos de ADN foráneos procedentes de otras bacterias o de infecciones con virus, estas secuencias se heredan a la siguiente generación, de modo que generan protección ante futuras infecciones. Estas secuencias CRISPR son acompañadas de cerca por un gen denominado Cas (CRISPR associated), cuyo producto es una proteína capaz de cortar la doble cadena de ADN. La clave es comprender que una secuencia específica (espaciadora) de CRISPR (crRNA) en combinación con la proteína Cas tienen la habilidad de localizar una región de ADN complementaria y cortar el ADN doble cadena y degradarlo (figura A).

Jennifer Doudna y Emmanuelle Charpentier contribuyeron con aportes relevantes para comprender CRISPR-Cas. Mientras que Doudna describió en 2009 la estructura y los dominios catalíticos de Cas, es decir las partes de la proteína responsables de su actividad endonucleasa, Charpentier descubrió la función del ARN transactivador de CRISPR (tracrRNA), una tercera molécula que ayuda a estabilizar la proteína Cas junto con el ARN guía para cortar el ADN. Sin embargo, ellas no recibieron el premio Nobel por estos avances.

La Real Academia de Ciencias Sueca las premió por su publicación de 2012, titulada ‘Una endonucleasa programable guiada por un ARN dual para la inmunidad adaptativa bacteriana’ (ver Jinek M et al., 2012, en las lecturas sugeridas). En resumen, en esa publicación ellas propusieron que modificando este sistema natural de defensa bacteriana se podía convertir en un sistema extremadamente simple y eficiente de localización y corte de ADN no solo para bacterias, sino que podía ser una herramienta para modificar cualquier genoma en un tubo de ensayo (figura B). Literalmente, el primer paso para modificar la información genética de cualquier ser vivo.

Para ello, y considerando que las bacterias (procariotas) son diferentes de las células eucariotas, donde la información genética se encuentra dentro del núcleo, el desafío para usar este sistema de edición de genes sería lograr que estas ‘tijeras programables’ funcionen dentro de esta organela. Feng Zhang (Broad Institute, Harvard-MIT) lo logró en 2013, y CRISPR-Cas se convirtió en el sistema más utilizado para la pérdida de función de genes (knock-outs), lo que facilitó enormemente la generación de modelos celulares de enfermedades humanas. Sin embargo, las posibilidades de transformación de este sistema recién comenzaban y rápidamente superaría los límites de la imaginación de los más ocurrentes, con aplicaciones en biomedicina, biotecnología, agricultura y medio ambiente. Las aplicaciones de las diversas variantes del sistema CRISPR-Cas original en la salud permitieron interrogar sobre la función biológica de diversas regiones del genoma, evitar la replicación del virus de la hepatitis C en células humanas, o instalar o revertir mutaciones puntuales relacionadas con enfermedades humanas, como en la anemia falciforme o la enfermedad de Tay-Sachs. El potencial de esta herramienta es enorme. Este sistema podría, teóricamente, corregir hasta el 90% de las enfermedades genéticas conocidas en nuestra especie.

La idea de corregir la información genética y, así, curar enfermedades es sin dudas un viejo sueño humano. CRISPR no caminaba aun cuando en 1997 se estrenó la película Gattaca, que cuenta la historia de un escenario distópico donde avances en la ingeniería genética permiten que los seres humanos puedan ser ‘mejorados’. Esto hacía que aquellos humanos ‘perfeccionados’ tuviesen la posibilidad de mejor salud y acceso a trabajos y oportunidades superiores, mientras que aquellos que contaban con una genética ‘natural’ quedaban relegados. El personaje principal, sin ayuda de la ciencia, no se rinde frente a su sueño de ser astronauta, y mediante fraudes y engaños intenta esquivar los controles del sistema, planteando a fines del siglo XX el dilema de la edición génica y su ética. Con Doudna y Charpentier, CRISPR-Cas como herramienta de edición logró subirse a los hombros de las tecnologías genómicas y de terapia génica, dando un salto enorme en el área. Hoy hay más de cuarenta ensayos clínicos aprobados con técnicas CRISPR y su crecimiento no se detiene, habiendo aumentado en 30% solo en el último año. Entre ellos se cuentan ensayos para la cura de enfermedades de la sangre, tumores sólidos, leucemias y linfomas. Pero volvamos a las implicancias éticas de la edición génica: la condición para realizar cualquier ensayo en humanos es que CRISPR no afecte la línea germinal, es decir, óvulos y espermatozoides, ya que transmiten los genes a la siguiente generación. Hay un acuerdo internacional de la comunidad científica para evitar las potenciales aplicaciones de esta tecnología para ‘mejorar’ la especie. No respetarla genera descrédito y, como ya ha ocurrido, sanciones penales. La discusión ética aún prosigue.

Sin dudas, CRISPR merecía un premio Nobel. Podríamos discutir si las galardonadas son las únicas merecedoras o no, ya que la ciencia siempre se construye a hombros de descubrimientos sucesivos y escalonados, donde es difícil discernir cuál fue el salto clave. Lo que resulta indiscutible es que este sistema, originado en los organismos vivos más simples, nos ofrece una herramienta poderosa y fascinante para modificar nuestro mundo. Comprenderla de forma racional y utilizarla de forma responsable para el beneficio de todos son desafíos ineludibles a los que nos enfrentamos como especie.

Lecturas sugeridas

Anzalone AV, Koblan LW & Liu DR, 2020, ‘Genome editing with CRISPR–Cas nucleases, base editors, transposases and prime editors’, Nature Biotechnology, 38, 7: 824-844.

Jinek M et al., 2012, ‘A programmable dual-RNA-guided DNA endonuclease in adaptive bacterial immunity’, Science, 337 (6096): 816-821.

Mojica FJM et al., 2005, ‘Intervening sequences of regularly spaced prokaryotic repeats derive from foreign genetic elements’, Journal of Molecular Evolution, 60: 174-182.

Montoliu L, 2020, Editando genes: recorta, pega y colorea. Las maravillosas herramientas CRISPR, Next Door Publishers, 2a. edición.

Pickar-Oliver A & Gersbach CA, 2019, ‘The next generation of CRISPR–Cas technologies and applications’, Nature reviews Molecular cell biology, 20, 8: 490-507.

Hernán Dopazo

Facultad de Ciencias Exactas y Naturales, UBA

FISICA

Agujeros negros: teoría y observación

l premio Nobel de Física de 2020 fue otorgado a Roger Penrose (Colchester, Reino Unido, 1931), Reinhard Genzel (Bad Homburg vor der Höhe, Alemania, 1952) y Andrea Ghez (Nueva York, Estados Unidos, 1965) por la Real Academia de Ciencias de Suecia, en reconocimiento a sus investigaciones acerca de los agujeros negros. La mitad del premio corresponde a Roger Penrose por mostrar, en la década de 1960 usando técnicas matemáticas novedosas, que bajo hipótesis muy generales los agujeros negros pueden formarse de manera natural por colapso gravitatorio en el marco de la teoría de la relatividad general, y por describir estos objetos en detalle. Reinhard Genzel y Andrea Ghez comparten la otra mitad del premio por el descubrimiento del objeto compacto supermasivo (más de un millón de veces la masa de nuestro Sol) que se encuentra en el centro de nuestra galaxia –la Vía Láctea–, mediante la observación de las órbitas de las estrellas más cercanas que giran a su alrededor. Los períodos de estas órbitas requieren que haya un objeto compacto, con una masa de unos cuatro millones de masas solares dentro de una región más pequeña que la de nuestro sistema solar, o sea que se trata de un agujero negro.

La idea de objetos cuya gravedad es tan fuerte que la luz no puede escapar de ellos se remonta a fines del siglo XVIII con los trabajos del geólogo inglés John Michell (1724-1793) y del matemático francés Pierre-Simon Laplace (1749-1827), realizados en el contexto de la teoría corpuscular de la luz y de la gravedad de Newton. La gravedad newtoniana fue superada por la teoría de la relatividad general que Albert Einstein completó a fines de 1915, y que permitió explicar la denominada anomalía del perihelio del planeta Mercurio e hizo otras predicciones que se verificaron desde entonces. La solución a las ecuaciones de la teoría de Einstein con simetría esférica fue encontrada en 1916 por el físico y astrónomo alemán Karl Schwarzschild (1873-1916) y su resultado es la aparición de una singularidad, una ruptura del espacio-tiempo, rodeada por un horizonte de eventos, una frontera más allá de la cual no puede afectarse a un observador externo; en otras palabras, lo que actualmente llamamos agujero negro. Los físicos estadounidenses Robert Oppenheimer (1904-1967) y Hartland Snyder (1913-1962) mostraron, en 1939, que el agujero negro de Schwarzschild puede formarse por el colapso de una nube esférica de materia.

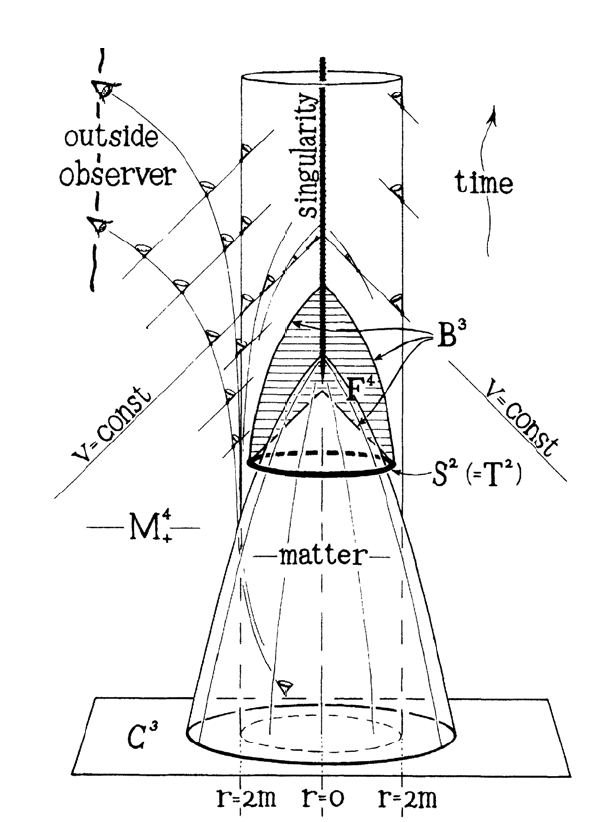

A comienzos de la década de 1960 se descubre que los cuásares, observados por primera vez unos pocos años antes, eran objetos extremadamente brillantes ubicados en el centro de galaxias lejanas y con una luminosidad cien veces mayor que la de una galaxia típica. La enorme radiación emitida por estos objetos podía explicarse por la acreción –agregado de materia– sobre un objeto compacto de millones de masas solares. Por otro lado, en 1963 el físico neocelandés Roy Kerr (1934) halla una solución más realista a las ecuaciones de Einstein que corresponde a agujeros negros rotantes pues, en general, los objetos astronómicos poseen rotación. Sin embargo, persistían dudas acerca de si el colapso gravitatorio podría dar lugar a un agujero negro en el caso más general, es decir, sin simetría esférica. Roger Penrose resolvió el problema en 1965 sin usar la condición de simetría esférica y suponiendo solamente que la materia colapsada tiene una densidad de energía positiva. Para ello, tuvo que inventar nuevos métodos matemáticos, como el concepto de superficie atrapada, una superficie bidimensional cerrada con la propiedad de que todos los rayos de luz ortogonales a ella convergen cuando se trazan hacia el futuro. De este modo, una vez que se forma la superficie atrapada, el colapso de la materia es inevitable, y aparecen el horizonte de eventos y la singularidad en su interior. De la región dentro del horizonte de eventos nada puede escapar, ni siquiera la luz, y la materia termina finalmente en la singularidad, de densidad infinita. Este trabajo de Penrose fue el que le otorgó a la existencia física de los agujeros negros una fundamentación sólida. En los años siguientes, Penrose y el físico británico Stephen Hawking (1942-2018) alcanzaron resultados similares para el caso de la singularidad cósmica donde el universo surge a partir de una singularidad en el pasado y se expande hasta el presente. El modelo de la gran explosión (Big Bang) requiere una tal singularidad.

A partir de los trabajos del estadounidense Edwin Salpeter (1924-2008) y de los soviéticos Yakov Zeldovich (1914-1987) e Igor Novikov (1935) se llegó, a mediados de la década de 1960, al consenso de que la emisión de los cuásares es el resultado de la acreción de materia sobre agujeros negros de gran masa. A fines de esa década el británico Donald Lynden-Bell (1935-2018) presentó una descripción teórica detallada del fenómeno y sugirió que la mayoría de las galaxias, aun las no activas, albergan un agujero negro supermasivo en su centro y que la Vía Láctea no debería ser una excepción. En 1971, Roger Penrose y RM Floyd ampliaron una idea anticipada un par de años antes por Penrose, de que la energía rotacional de un agujero negro de Kerr puede servir para extraer energía de él. En 1977, los británicos Roger Blanford (1949) y Roman Znajek (1951) utilizaron el proceso de Penrose para obtener un modelo realista de producción de energía de agujeros negros rotantes, de modo que en presencia de campos magnéticos pueden actuar como dinamos gigantes. Se considera actualmente que este mecanismo juega un papel importante en muchos agujeros negros y sus chorros de materia (jets).

Pero la observación detallada de la región central de nuestra galaxia requirió el paso del tiempo y la aparición de nuevas tecnologías. Reinhard Genzel y Andrea Ghez desarrollaron, en forma independiente desde comienzos de la década de 1990, métodos para poder observar a través de las densas nubes de gas y polvo del centro de la Vía Láctea y refinaron las técnicas para compensar las distorsiones que produce la atmósfera terrestre. Los movimientos de las estrellas que orbitan el centro galáctico –ubicado a unos 26.000 años luz de nuestro planeta– fueron monitoreados durante casi tres décadas por dos grupos de observación, uno dirigido por Genzel en el Instituto Max Planck de Física Extraterrestre (MPE) de Alemania –que utilizó telescopios en Chile operados por el Observatorio Europeo Austral (ESO)– y el otro liderado por Ghez en la Universidad de California, Los Ángeles (UCLA) en Estados Unidos –que usó el Observatorio Keck en Hawái–.

Distinguir estrellas individuales que describen órbitas en la región muy poblada del centro galáctico requiere una excelente resolución espacial. El oscurecimiento debido al polvo interestelar en el centro de la Vía Láctea inhibe la observación en longitudes de onda en el rango visible, por lo cual los dos equipos llevaron a cabo sus observaciones en el infrarrojo cercano, lo que requirió instrumentos nuevos de mucha resolución y técnicas también novedosas. Por otro lado, las observaciones desde la Tierra sufren los cambios que ocurren en la atmósfera durante el largo tiempo de medición, para lo cual ambos grupos utilizaron técnicas de óptica adaptativa. ¿Por qué no usar telescopios espaciales? Porque resulta impráctico debido al largo tiempo de medición necesario para recuperar la señal y poder seguir las órbitas estelares alrededor del centro galáctico. La óptica adaptativa utiliza láseres para generar estrellas falsas que sirven para monitorear en tiempo real las distorsiones producidas por la atmósfera lo que permite, mediante cambios controlados en la forma de un espejo secundario, compensar las turbulencias del aire y corregir la imagen del objeto astronómico observado.

Los investigadores siguieron unas treinta de las estrellas más brillantes entre la multitud presente en el centro galáctico, alrededor de la fuente compacta de radio Sagitario A*. En particular una de ellas, denominada S2 o SO2, completa su órbita alrededor del centro de la galaxia en menos de dieciséis años. La interpretación –muy robusta– de estas observaciones es que el objeto compacto en el centro galáctico es un agujero negro de unos cuatro millones de masas solares.

Adicionalmente, los destellos de rayos X y en el infrarrojo cercano que se observan desde la misma posición pueden atribuirse naturalmente a variaciones en el flujo de acreción hacia un agujero negro de esta magnitud. Se suma además la reciente imagen del agujero negro supermasivo ubicado en el centro de la galaxia elíptica cercana M87, anunciada el año pasado por la colaboración Telescopio Horizonte de Eventos (EHT), que muestra una región oscura central rodeada por el disco de acreción. Se han producido grandes avances en la comprensión de estos enigmáticos objetos que dominan el centro de las galaxias.

Lecturas sugeridas

Eckart A & Genzel R, 1996, “Observations of stellar proper motions near the Galactic Centre”, Nature, 383: 415.

Ghez AM, Klein BL, Morris M & Becklin EE, 1998, “High proper-motion stars in the vicinity of Sagittarius A*: Evidence for a supermassive black hole at the center of our galaxy”, The Astrophysical Journal, 509: 678.

Hawking SW, 1965, “Occurrence of singularities in open universes”, Physical Review Letters, 15: 689.

Hawking SW & Penrose R, 1970, “The singularities of gravitational collapse and cosmology”, Proceedings of the Royal Society of London Series A, 314: 529.

Penrose R, 1965, “Gravitational collapse and space-time singularities”, Physical Review Letters, 14: 57.

Ernesto Fabián Eiroa

Instituto de Astronomía y Física del Espacio (IAFE), Conicet-UBA