¿Cuáles son las contribuciones al conocimiento realizadas por los ganadores de premios que, a lo largo de más de un siglo, se convirtieron en uno de los mejores mecanismos del mundo para identificar avances cruciales de las ciencias?

ECONOMÍA

¿Por qué el Nobel a economistas de los mercados financieros?

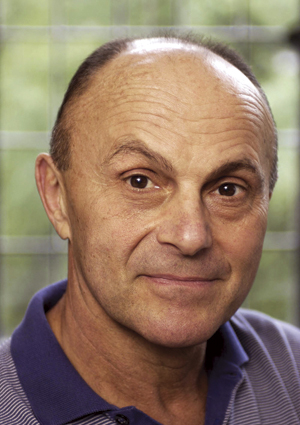

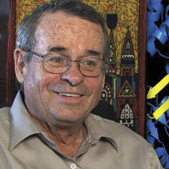

Tres economistas estadounidenses recibieron este año el premio de economía: Eugene Fama (nacido en 1939) y Lars Peter Hansen (nacido en 1952), de la Universidad de Chicago, y Robert J Shiller (nacido en 1946), de la Universidad de Yale. Fueron pioneros en el estudio de los diversos instrumentos financieros que cotizan en bolsas, como acciones, bonos y derivados, y ganaron el premio por su análisis empírico de los precios de activos financieros, en palabras de la entidad que lo otorga. No es la primera vez que economistas dedicados al estudio de mercados financieros resultaron galardonados con el Nobel, aunque, para buena parte de quienes son ajenos a la disciplina económica, ese tipo de estudios parece carecer de rigor científico, al punto de que la imagen popular del comportamiento del mercado de capitales no es muy distinta de la de un casino.

Sin embargo, existen varias razones que hacen relevante el estudio de los precios de los activos financieros y, por lo tanto, resaltan el aporte de los tres galardonados. Entre ellas se cuentan que esos precios suelen ser indicadores de la evolución futura de la producción y del empleo de mano de obra en distintos sectores. También son indicadores que ayudan a predecir crisis como la registrada en los Estados Unidos entre 2007 y 2008. Hay, pues, suficientes argumentos para aconsejar estudio sistemático y científico de tales precios.

Eugene Fama y la eficiencia informativa

De los tres premiados, Fama abrió rumbos en el estudio empírico sistemático de los precios de los activos financieros y de los retornos proporcionados por ellos. Sus contribuciones pueden dividirse en dos grandes grupos. El primero se refiere a la eficiencia informativa de los mercados de capitales, nombre que apunta a establecer en qué medida el precio de dichos activos refleja toda la información relevante sobre los factores que determinan ese precio. Sistematizó su análisis mediante la definición de tres grados sucesivos de eficiencia informativa: (i) eficiencia informativa débil, cuando el precio solo incorpora información pública pasada; (ii) eficiencia informativa semifuerte, cuando, además de la anterior, el precio incorpora información pública contemporánea, y (iii) eficiencia informativa fuerte, cuando el precio también incorpora información privada o interna de la respectiva empresa (inside information), es decir, refleja todo tipo de información relevante. Con esta clasificación, el análisis empírico permite determinar el grado de predictibilidad de los retornos de los activos en función de retornos pasados y de otras variables de conocimiento público.

Los estudios de Fama y de otros economistas llevaron a concluir que, para datos de precios de frecuencia diaria, los mercados tienden por lo general a comportarse en el marco de la eficiencia informativa débil o, en algunos casos, semifuerte. Por ello, la posibilidad de especular sobre la base de los retornos previsibles es cuantitativamente muy baja. El nivel de predictibilidad solo aumenta para plazos más largos.

La clasificación de la eficiencia informativa trascendió el estudio empírico de los precios de los activos. Resultó clave para el crecimiento de una rama de los estudios financieros, los de la microestructura del mercado, que analiza los mecanismos y procesos específicos de operación de los mercados. Una de las preguntas relevantes que intenta responder es qué mecanismos ayudan a que el precio de mercado de los activos financieros incorpore más rápidamente la información privada. A partir de esos estudios se han establecido métodos para inferir el grado de transacciones ilegales hechas valiéndose de información confidencial (insider trading) reinante en mercados de acciones.

En la década de 1960, William Sharpe (que recibió el premio Nobel de economía en 1990), John Litner y otros desarrollaron un modelo de valoración de activos conocido por CAPM (Capital Asset Pricing Model), que continúa como la referencia básica para explicar las diferencias en retornos esperados de distintos activos. Entre otros, Fama contribuyó a la generalización y el perfeccionamiento de los métodos de contrastación empírica del modelo y a agregarle nuevas variables, como el cociente entre el valor en libros y el valor de mercado. Esas correcciones fueron adoptadas para explicar características de los precios de activos, como las analizadas por la microestructura del mercado.

Lars Peter Hansen y los modelos teóricos de valuación

En la década de 1970, Robert Lucas (que recibió el Nobel de economía en 1995) analizó las limitaciones de los modelos macroeconómicos keynesianos entonces aceptados para identificar y predecir los efectos de las políticas económicas. Su análisis es hoy conocido como la crítica de Lucas, una respuesta que se debe a Christopher Sims (premio Nobel de economía en 2011), quien sugirió recurrir a un sistema estadístico dinámico, llamado de vectores autorregresivos.

Hansen adoptó una ruta diferente, la del método generalizado de momentos, que es una extensión del clásico método estadístico y permite que la cantidad de restricciones impuestas por la teoría exceda el número de parámetros a estimar. Para aplicarlo utilizó un modelo de valuación de activos financieros creado por Lucas en 1978, que se había convertido en uno de los instrumentos teóricos más importantes después del modelo CAPM.

A comienzos de la década de 1980 y en colaboración con Kenneth Singleton, sometió a dicho modelo de Lucas a su primera prueba empírica importante utilizando datos sobre consumo de los Estados Unidos sobre retornos de acciones cotizadas en la bolsa de Nueva York. Su trabajo originó decenas de artículos a lo largo de treinta años que procuraron, con éxitos solo parciales, superar las limitaciones del modelo para que sus resultados fuesen consistentes con los datos empíricos.

El trabajo de Hansen guió una parte sustancial de la economía empírica de los últimos treinta años. Su influencia fue más allá de la macroeconomía y las finanzas, y alcanzó áreas como la economía laboral o la organización industrial.

Robert J Shiller y la predictibilidad de los retornos en el largo plazo

La primera contribución de peso de Shiller fue mostrar que el nivel de predictibilidad en el largo plazo de los valores de los activos financieros es mayor que en el corto plazo. Comprobó que el error de predicción –definido como la diferencia entre el precio observado y el precio que predice un modelo teórico basado en los dividendos– está correlacionado con el propio precio observado.

Dada esa conclusión, no buscó explicar los rendimientos en el largo plazo mediante nuevos métodos empíricos. Buscó, en cambio, tomar en cuenta variables psicológicas y modas que pudiesen tener efecto directo en el precio de los activos, especialmente las relacionadas con comportamientos de masas. Las conclusiones de sus primeros trabajos fueron confirmadas por estudios empíricos basados en encuestas de inversores. Sus ideas merecieron un reconocimiento importante cuando explicó irregularidades en mercados de activos financieros y, especialmente, en el mercado de viviendas. Con su colega Karl Case analizó el comportamiento de un índice de precios de viviendas que habían ideado, e infirió la existencia de burbujas inmobiliarias en ciudades de los Estados Unidos como Boston.

Sus trabajos aumentaron el interés por los factores de comportamiento en los modelos económicos y en las teorías que tomaban ideas de la psicología, como la desarrollada por Daniel Kahneman (premio Nobel de economía en 2002) y Amos Tversky. Ese interés tomó envergadura y generó lo que algunos llaan las finanzas del comportamiento (behavioural finance), una rama que ganó influencia, especialmente después de las crisis financieras de los Estados Unidos y Europa. Los libros de divulgación escritos por el propio Shiller sobre cómo los factores de comportamiento pueden distorsionar las predicciones sobre retornos de los modelos estándar apuntalaron ese incremento de influencia.

Lecturas sugeridas

REAL ACADEMIA SUECA DE CIENCIAS, 2013, ‘Understanding asset prices’, en http://www.nobelprize.org/nobel_prizes/economic-sciences/laureates/2013/ advanced-economicsciences2013.pdf

DATOS AUTORES

Enrique Kawamura

PhD en economía, Universidad de Cornell.

Profesor asociado del departamento de economía, Universidad de San Andrés.

[email protected]

Walter Sosa Escudero

PhD en economía, Universidad de Illinois.

Profesor asociado del departamento de economía, Universidad de San Andrés.

[email protected]

FISICA

El bosón de Higgs y el origen de la masa

El galardón de física 2013 fue otorgado al belga François Englert (nacido en 1932), de la universidad Libre de Bruselas, y al británico Peter Higgs (nacido en 1929), de la Universidad de Edimburgo, por el descubrimiento teórico del mecanismo que contribuye a nuestra comprensión del origen de la masa de las partículas subatómicas, que fuera confirmado recientemente por el descubrimiento de la partícula fundamental predicha con los experimentos Atlas y CMS en el gran colisionador de hadrones del CERN, en palabras de la Real Academia Sueca. ¿Qué quiere decir esto?

El concepto de masa resulta de la ley de Newton que establece la siguiente relación entre la fuerza (F) aplicada a un cuerpo y la aceleración (a) que este alcanza: F = ma. La masa indica la resistencia de un objeto a moverse: como se advierte, un cuerpo de 100kg requiere diez veces más fuerza que uno de 10kg para alcanzar la misma aceleración. El kilogramo, a su vez, se definió como la masa de un objeto cilíndrico patrón, de 39,17 milímetros de altura y diámetro, construido de cierta aleación de platino-iridio. Intuitivamente se tiende a confundir masa con peso, que es la fuerza sufrida por los cuerpos debido a la atracción gravitatoria de la Tierra. La masa, sin embargo, es independiente de la gravedad: en el espacio interplanetario, con gravedad nula, los objetos no caen, pero para desplazarlos se sigue necesitando una fuerza de intensidad proporcional a su masa.

Comprender el concepto de masa no explica su origen. Para ello hay que considerar la composición de los cuerpos. A lo largo de siglo XX la física avanzó en su comprensión de la estructura de la materia, la que culminó con una construcción matemática llamada el modelo estándar de las interacciones fundamentales. Según ese modelo, todo –las flores, la gente, las estrellas, los planetas– está hecho de unos pocos constituyentes: las partículas elementales. Estas son objetos puntuales (con la extensión de un punto, o sea, teóricamente, sin tamaño) que interactúan entre ellos a distancia, como dos imanes que se repelen o se atraen sin tocarse.

Que la materia esté compuesta por objetos sin dimensión rodeados de vacío contradice la experiencia diaria, para la cual los cuerpos que nos rodean son macizos. Así nos resultan por dos razones. Primero, al apoyarnos en una mesa no la atravesamos porque las partículas que constituyen nuestro cuerpo se repelen fuertemente con las que constituyen la mesa. Segundo, porque la luz visible a la que estamos acostumbrados rebota en los cuerpos en vez de atravesarlos, pues si bien ellos están hechos de vacío y objetos puntuales, dicha luz rebota en esos objetos sin tamaño, aunque luces de mayor energía que la visible, como los rayos X y los rayos gama, atraviesan la materia sin mayor dificultad.

Si intuitivamente asociamos más masa con más tamaño, ¿qué sentido tiene hablar de la masa de un objeto puntual? El muón, en efecto, que es una partícula elemental, tiene una masa 208 veces mayor que el electrón, otra partícula elemental. La respuesta de Englert y Higgs es que el universo está permeado de una energía, hoy denominada el campo de Higgs, que actúa como una melaza cósmica que interactúa con las partículas. Las que interactúan mucho con esa melaza tienen elevada masa y cuesta moverlas; las que interactúan menos con la melaza tienen menos masa y se las mueve más fácilmente. Y las que no interactúan, como el fotón, la partícula que transmite la luz, carecen de masa. La masa no es otra cosa que la medida de cuánto interactúa una partícula con el campo de Higgs. Se dice que este las dota de masa: si no existiera, todas las partículas elementales tendrían masa cero y se moverían por el espacio a la velocidad de la luz. No habría átomos, y no existiríamos nosotros.

Englert y Higgs llegaron a esta explicación tratando de resolver otra cuestión: la masa es incompatible con las simetrías del modelo estándar. Para la física y la matemática, una simetría es una propiedad de un sistema que se conserva cuando este se transforma, como la longitud de una regla cuando se la mueve o gira en el espacio, el aspecto de un obelisco al rotarlo 90 grados alrededor de su eje, o la fachada del Cabildo al invertirla de izquierda a derecha. En 1954, los físicos teóricos Chen Ning Yang (nacido en 1922) y Robert Mills (1927-1999) mostraron que todas las interacciones fundamentales eran el resultado de que la naturaleza trataba de mantener ciertas simetrías, como la conservación de la carga eléctrica en el caso del electromagnetismo, o la conservación de la energía y el momento en el caso de la gravedad de Einstein. Basar una teoría en un concepto tan fundamental como las simetrías de la naturaleza le confiere importantes propiedades matemáticas que aseguran su consistencia interna. Sin embargo, una consecuencia directa de las simetrías en que se basa el modelo estándar es que las partículas elementales que lo componen requieren tener masa cero. Dicho de otro modo, la observación experimental de que las partículas tienen masa viola las simetrías en que la propia teoría se apoya.

En 1960, el profesor de la Universidad de Chicago Yoichiro Nambu (nacido en Tokio en 1921) señaló un camino para salir del dilema anterior: mostró que las leyes de la física pueden poseer ciertas simetrías que no se observan en la naturaleza. Ello le valió el premio Nobel en 2008. Su idea fue la ruptura espontánea de la simetría y puede explicarse considerando un lápiz cilíndrico en posición vertical apoyado sobre su punta en el centro de una mesa circular. Se dice que es una situación de simetría rotacional, pues desde cualquier posición alrededor de la mesa se ve lo mismo: todas las direcciones de la mesa son equivalentes. Si el lápiz cae, sin embargo, termina apuntando en una dirección determinada. La simetría inicial se rompe y las posiciones alrededor de la mesa dejan de ser equivalentes, a pesar de haber partido de una situación con simetría rotacional.

En 1964 tres grupos de físicos mostraron matemáticamente cómo aplicar el mecanismo de rotura espontánea de la simetría al dilema de la masa. El modelo estándar equivaldría al lápiz vertical, que obedece la simetría de rotación. El mundo que observamos, al lápiz horizontal, que tuvo que elegir una dirección. Así, de entre muchas posibilidades equivalentes, simétricas entre sí, nuestro universo tuvo que elegir una, en la que la simetría no es evidente, en la que existe el campo de Higgs como la melaza que impregna el espacio, y en la que las partículas elementales adquirieron masa. Es decir, aunque las leyes de la física sean simétricas, pueden dar lugar a un universo que no manifieste esa simetría.

Los primeros en publicar esta idea fueron François Englert y su colega Robert Brout (1928-2011). Peter Higgs la publicó dos semanas más tarde, pero fue el primero en señalar que la teoría predecía la existencia de una nueva partícula: el ahora famoso bosón que lleva su nombre. Bosón es un término técnico para referirse a cierta clase de partículas, entre ellas las que se ven igual desde cualquier dirección que se observen (técnicamente, tienen espín cero). De manera paralela y sin conocer lo hecho público por los anteriores, otros tres físicos, el británico Tom Kibble (nacido en 1932), del Imperial College de Londres, y los estadounidenses Carl Hagen (nacido en 1937), de la Universidad de Rochester, y Gerald Guralnik (nacido en 1936), de la Universidad Brown, escribían un trabajo que enviaron a publicar al mes de haber salido el de Higgs. Se puede suponer que Brout hubiera compartido el Nobel de haber vivido, y quizá los otros tres lo hubieran recibido de permitirse más de tres galardonados simultáneos.

Para verificar de modo experimental la teoría se puso en movimiento la búsqueda del bosón de Higgs, que terminó popularmente conocido (no entre los físicos) como la partícula de Dios, por el título de un libro de divulgación sobre el tema. Esa búsqueda –como la de otras partículas– se basó en una de la leyes más famosas de la física, E = mc², que indica la equivalencia de la masa y la energía. Así, la masa se transforma en energía en centrales nucleares, donde la primera desaparece y se obtiene energía térmica (que se a su vez se transforma en eléctrica). El proceso inverso tiene lugar en un colisionador, donde la energía cinética de las partículas se transforma parcialmente en masa, esto es, en nuevas partículas. La búsqueda del bosón de Higgs se realizó en varios colisionadores de distinta energía, entre ellos el que tuvo éxito, el gran colisionador de hadrones, emplazado en el laboratorio del Centro Europeo de Investigación Nuclear (CERN), en la frontera franco-suiza cerca de Ginebra.

La búsqueda culminó el 4 de julio de 2012, cuando se anunció en el CERN en una conferencia de prensa –en la que estuvieron presentes Englert, Higgs y Kibble– que en dos experimentos llamados respectivamente Atlas (del que son miembros la UBA y la Universidad Nacional de La Plata) y CMS se había detectado la largamente buscada partícula, y que sus propiedades comprobadas coincidían exactamente con las predichas por la imaginativa teoría concebida cuarenta y nueve años antes.

Sin embargo, este no es el final de la historia. Con el bosón de Higgs incorporado, el modelo estándar explica todos los resultados experimentales hallados a la fecha, pero es incompleto. No incorpora la interacción gravitatoria, no incluye la materia oscura que compone más de un cuarto del universo y no describe la naturaleza de la energía oscura, considerada responsable de la expansión cósmica, por citar unos ejemplos. La búsqueda de las leyes que gobiernan la naturaleza continúa.

Lecturas sugeridas

DOVA MT, 1998, ‘En busca del origen de la masa’, Ciencia Hoy, 8, 47: 60-66.

LEDERMAN L & TERESI D, 1993, The God Particle. If the Universe Is the Answer, What Is the Question?, Dell Publishing, Nueva York.

RANDALL L, 2013, Higgs’ Discovery: The Power of Empty Space, Bodley Head.

REAL ACADEMIA SUECA DE CIENCIAS, 2013, ‘Here at last!’, en http://www.nobelprize.org/nobel_prizes/ physics/laureates/2013/popular-physicsprize2013.pdf

Ricardo Piegaia

PhD en física, Universidad de Yale.

Investigador principal del Conicet en el Instituto de Física de Buenos Aires.

Profesor titular de la FCEYN, UBA.

[email protected]

MEDICINA O FISIOLOGÍA

Nuestro tráfico celular de cada día

El premio Nobel de fisiología o medicina fue otorgado a tres investigadores, en palabras de la Real Academia de Suecia, por sus descubrimientos de la maquinaria que regula el tráfico vesicular, el mayor sistema de transporte en nuestras células. Los galardonados fueron tres norteamericanos, James Rothman (nacido en 1947), de la Universidad de Yale, Randy Schekman (nacido en 1948), de la Universidad de California en Berkeley, y Thomas C Südhof (nacido en Alemania en 1955), de la Universidad de Stanford.

Para comprender la importancia del trabajo de los nombrados, primero tenemos que sumergirnos en un mundo microscópico. Nuestro cuerpo –así como también las plantas, los animales y toda criatura viviente de nuestro planeta– está formado por millones de células, las unidades básicas de la vida. La complejidad del cuerpo humano se debe en gran parte al alto grado de especialización de nuestras células: tenemos más de doscientos tipos de ellas, entre las que se cuentan las neuronas, que transmiten información por todo el organismo y almacenan memorias en el cerebro; los hepatocitos, que protegen de sustancias tóxicas; las células del páncreas que producen insulina, y los cardiocitos que mantienen el ritmo del corazón. La gran variabilidad de las células abarca tanto su morfología y su tamaño como sus funciones.

Pero a pesar de sus diferencias, todas las células tienen algunos mecanismos en común relacionados con sus funciones básicas, una de las cuales es el transporte o tráfico intracelular. Las células son capaces de producir componentes de su propia estructura, particularmente miles de proteínas. Pero esas proteínas, así como otras moléculas clave para la vida de la célula, deben ser transportadas en el momento adecuado desde su punto de origen hasta su lugar exacto de destino dentro de la misma célula. De ahí la importancia del tráfico intracelular, realizado por mecanismos que están regulados con la mayor precisión para evitar errores que serían desastrosos. Los investigadores premiados estudiaron en detalle dichos mecanismos.

Para llevar a cabo el tráfico en cuestión, las células hacen uso de unos pequeños medios de transporte conocidos como vesículas. Podemos imaginar las vesículas como minúsculas burbujas que llevan carga en su interior o en su superficie, que salen de un compartimento celular interno –como el retículo endoplásmico, donde se produce gran parte de las proteínas celulares– y se dirigen a otro sitio dentro de la célula, en el que esa carga es requerida. Así, la insulina –que químicamente es una proteína generada dentro de las células pancreáticas– resulta transportada por las vesículas a la superficie de esas células, sale de ellas y se distribuye al resto del cuerpo por el torrente sanguíneo. El mecanismo regulatorio conduce las vesículas cargadas de manera precisa desde el lugar donde las proteínas se forman (o sintetizan), en el que las cargan, hasta el lugar en que deben entregarlas, en el que las descargan.

Schekman estudió los procesos de regulación del tráfico en unos organismos sencillos, las levaduras (Saccharomyces cerevisiae), que son los hongos responsables de la fermentación del pan, la cerveza y el vino. Aunque simples, tienen muchas características en común con nuestras células, lo que le permitió identificar y describir un gran número de los componentes que intervienen en la regulación de su tráfico vesicular. Sus investigaciones significaron un gran aporte a la industria biotecnológica, pues permitieron obtener en gran escala productos farmacológicos, entre otros insulina, interferón y la vacuna contra la hepatitis B.

Por su lado, Rothman estudió el transporte celular de los mamíferos y descubrió un grupo de proteínas especializadas que asegura la llegada de la carga de las vesículas al lugar correcto. Están en la superficie de las vesículas y reconocen a otras proteínas solo presentes en la ubicación de destino, lo que permite que las membranas de la vesícula y del sitio de descarga se fusionen como si fueran dos gotas de aceite. Así, la carga termina donde debía llegar.

Südhof investigó células nerviosas o neuronas, que transmiten información por procesos electroquímicos en que intervienen los neurotransmisores, unas moléculas también transportadas a destino por vesículas. Los neurotransmisores se acumulan en los axones, fibras nerviosas que se encuentran en uno de los extremos de las neuronas. Cuando les llega el impulso nervioso, las vesículas se fusionan con la membrana del axón y liberan gran cantidad de neurotransmisores, los cuales se dirigen a la puerta de entrada de la siguiente neurona, una prolongación conocida como dendrita. Se inicia así una secuencia de señales que prolongan el impulso y en corto tiempo le permiten cubrir grandes distancias, como la que existe del cerebro a la punta de los dedos del pie. Südhof describió cómo se regula la liberación de los neurotransmisores en el espacio entre axones y dendritas, conocido como sinapsis. El mecanismo que descubrió guarda gran similitud con el que describieron Rothman y Schekman.

Los procesos del transporte vesicular también participan activamente en el funcionamiento de nuestro sistema inmune, que nos protege ante invasiones de virus, bacterias, hongos y parásitos. Cualquier perturbación de sus delicados mecanismos puede llevar a consecuencias graves para el organismo, lo que sucede en ciertas enfermedades neurológicas, la diabetes o determinados trastornos inmunológicos. Por eso, los hallazgos de los premiados han permitido entender mejor el origen de numerosas enfermedades relacionadas con defectos en el funcionamiento del transporte por vesículas.

Lecturas sugeridas

ZIERATH JR & LENDAHL U, 2013, ‘Machinery Regulating Vesicle Traffic, A Major Transport System in our Cells’, en http://www.nobelprize.org/nobel_prizes/medicine/ laureates/2013/advanced-medicineprize2013.pdf

Alberto Díaz Añel

Doctor en química biológica, UBA.

Investigador adjunto del Conicet en el Instituto de Investigación Médica Mercedes y Martín Ferreyra.

[email protected]

QUÍMICA

Las multiples escalas de la química

Todas las cosas que vemos o tocamos están compuestas por átomos, los que a su vez suelen agruparse y organizarse para formar moléculas. De tamaño aproximadamente un millón de veces menor que un milímetro, las moléculas giran, avanzan, oscilan, se rompen y forman otras, todo en lapsos que los relojes más precisos tendrían dificultad en medir. Esa danza microscópica de moléculas que se disocian y se reorganizan determina las propiedades y las transformaciones de la materia, incluso las reacciones químicas.

Desde comienzos de la década de 1970 y con más ímpetu en las décadas siguientes, investigadores en química, física, biología y computación han desarrollado y utilizado algoritmos matemáticos para representar y predecir, con el auxilio de una computadora, las estructuras, los movimientos y las transformaciones de las moléculas. Cobró así importancia la disciplina que se conoce como química computacional. Los galardonados este año con el premio Nobel de química fueron tres paladines de esa epopeya. Ellos son Martin Karplus (nacido en Austria en 1930), profesor emérito de la Universidad de Harvard y visitante en la de Estrasburgo; Michael Levitt (nacido en Sudáfrica en 1947), profesor de la Universidad de Stanford, y Arieh Warshel (nacido en Israel en 1940), profesor de la Universidad del Sur de California. Los tres hicieron aportes fundamentales a la disciplina, que hace uso de modelos matemáticos basados en la mecánica clásica, la mecánica cuántica y en la termodinámica estadística para simular las interacciones entre los átomos de las sustancias y obtener información sobre su comportamiento individual y colectivo.

La química computacional procura explicar los fenómenos químicos, y también diseñar nuevas moléculas, materiales o procesos moleculares, lo que puede implicar el diseño de un medicamento con determinadas propiedades o un material con características ópticas o eléctricas particulares, igual que interpretar el mecanismo de acción de una sustancia patógena en su interacción con una proteína. En algunas situaciones el camino de la química computacional puede ser preferible o complementario al experimental, especialmente si hacer experimentos requiere embarcarse en procedimientos arduos o costosos, o si las propiedades de interés son muy difíciles de medir. En cambio, el juego virtual en la computadora, que usa los átomos como ladrillos de un Lego, permite obtener información detallada de todo lo que le sucede al sistema.

El inconveniente es que los modelos que se han conseguido crear resultan exactos solo para tratar sistemas de muy pocos átomos, mientras los problemas más relevantes incluyen a menudo gran cantidad de ellos, y con muchos átomos la complejidad matemática se torna rápidamente inmanejable, incluso para una computadora. Esos modelos más complejos recurren a la mecánica cuántica y son los necesarios para describir reacciones químicas. Con la mecánica clásica se pueden crear modelos simplificados, que son menos demandantes computacionalmente y por ello permiten manejar sistemas de miles de átomos, como las biomoléculas, pero solo para fenómenos que no impliquen formación o ruptura de enlaces químicos.

La idea original que puso a Karplus, Levitt y Warshel en el camino del premio Nobel fue combinar diferentes modelos para crear los llamados métodos de multiescala. Éstas son técnicas de simulación química que emplean descripciones distintas en diferentes regiones del sistema. Las más usadas corresponden a los modelos híbridos cuántico-clásicos, conocidos por QM-MM (de quantum mechanics-molecular mechanics). Describen mediante la mecánica cuántica la región de un sistema que desea estudiarse con mayor detalle, mientras que el resto, llamado normalmente entorno, se modela con ecuaciones de menor complejidad correspondientes a la mecánica clásica. De esta manera se pueden abordar problemas que de otro modo estarían fuera de alcance. Además, reflejan la forma natural de ver las cosas de los químicos, que diferencian las regiones de interés o reactivas de los sistemas, por ejemplo, un soluto o el sitio activo de una proteína, de su entorno, que serían el solvente o la matriz proteica.

El uso de la simulación computacional se está convirtiendo en una herramienta casi imprescindible en la química actual. En la medida en que los experimentos se vuelven cada vez más complejos y apuntan a comprender fenómenos en la escala molecular, la interpretación de los resultados también se torna más compleja. En tal contexto, se ha incrementado la interacción de los químicos experimentales con los computacionales, y han cambiado sus alcances. Sven Lidin, químico experimental y presidente del comité de química del Nobel, manifestó en una entrevista: Cuando era un joven químico, nuestros colegas dedicados a la teoría se acercaban a discutir sus ideas sobre el comportamiento de los sistemas. Si sus resultados no contradecían nuestras observaciones, se iban contentos. Si había desacuerdo, estábamos seguros de que algo fallaba en su análisis. Hoy, si la teoría prueba o desaprueba algo en oposición a nuestras observaciones, normalmente damos un paso atrás y revisamos los experimentos, pues es igualmente probable que seamos nosotros los que estamos en el camino equivocado. En la Argentina hay numerosos ejemplos felices de esta interacción.

El otorgamiento de este premio, el quinto concedido a la química teórica, es un reconocimiento del grado de desarrollo que esta ha alcanzado y de su importancia actual. Los cuatro anteriores fueron los otorgados a Linus Pauling (1954), Robert Mulliken (1966), Roald Hoffman (1981) y John Pople y Walter Kohn (1998), y premiaron las contribuciones de los nombrados a la comprensión de los enlaces químicos y la formulación de métodos cuánticos. En esta ocasión, le llegó el reconocimiento a los métodos clásicos y su integración en modelos cuánticos.

Las historias de los tres laureados se entrecruzan en el tiempo. Warshel y Levitt iniciaron su colaboración a fines de la década de 1960, en el Instituto Weizmann, cuando aún no se habían doctorado. Warshel se incorporó al grupo de investigación de Karplus, en la Universidad de Harvard, a comienzos de la década de 1970, y juntos concibieron el primer modelo que combinó tratamientos clásicos y cuánticos. De regreso en Israel, Warshel reanudó su colaboración con Levitt y abordaron la simulación de biomoléculas, que los llevó a desarrollar y a aplicar los métodos QM-MM que se utilizan hoy. Mientras tanto, Karplus realizó innumerables aportes en ámbitos como la termodinámica estadística, la biología estructural y la espectroscopia de resonancia magnética. Linus Pauling, que fuera su maestro en la década de 1950, lo consideró su alumno más brillante.

Suele decirse que existen dos tipos de premios Nobel. Por un lado, los que reconocen un preciso descubrimiento o una idea concreta, valorados casi de inmediato por la comunidad científica. Normalmente se otorgan pocos años después del respectivo hallazgo. De ese tipo fueron las distinciones otorgadas a Albert Einstein por el efecto fotoeléctrico, a Francis Crick y James Watson por la estructura del ADN, a Gerd Binnig y Heinrich Rohrer por el microscopio de efecto túnel, o a César Milstein por los anticuerpos monoclonales. Por otro lado, están los premios que distinguen una sucesión de aportes, una trayectoria de investigación que produjo avances significativos en determinado campo. El que comentamos en esta nota es de esta segunda clase. Por ello tal vez no era fácil de anticipar, y sorprendió especialmente a los que trabajamos en química teórica y computacional. Por cierto, una muy grata sorpresa.

Lecturas sugeridas

MALMSTRÖM BG & ANDERSSON B, 2013, ‘The Nobel Prize in Chemistry: The Development of Modern Chemistry’, en http://www.nobelprize.org/nobel_prizes/themes/chemistry/malmstrom/index.html.

REAL ACADEMIA SUECA DE CIENCIAS, 2013, ‘Development of Multiscale Models for Complex Chemical Systems’, en http://www.nobelprize.org/nobel_prizes/chemistry/laureates/2013/ advanced.html.

Damián A Scherlis

Doctor en ciencias químicas, UBA.

Investigador independiente del Conicet en el Instituto de Química Física de los Materiales, Medioambiente y Energía (INQUIMAE).

Profesor adjunto de la FCEYN, UBA.

[email protected]

Darío A Estrin

Doctor en química, UNLP.

Investigador superior del Conicet en el INQUIMAE.

Profesor titular de la FCEYN, UBA.

[email protected]