¿Cuáles son las contribuciones al conocimiento realizadas por los ganadores de premios que, a lo largo de más de un siglo, se convirtieron en uno de los mejores mecanismos del mundo para identificar avances cruciales de las ciencias?

FISIOLOGÍA O MEDICINA

Premio a la ciencia básica, impulso al desarrollo traslacional

Este año, el premio Nobel en fisiología y medicina fue otorgado a los científicos estadounidenses David Julius, de la Universidad de California, en San Francisco, y Ardem Patapoutian, de origen libanés, investigador del Instituto de Investigaciones Scripps, en reconocimiento de sus descubrimientos sobre los mecanismos de percepción de la temperatura, el tacto, la presión y el dolor. Los hallazgos de los dos premiados ‘han permitido entender cómo el calor, el frío y la fuerza mecánica pueden generar impulsos nerviosos que nos permiten percibir el mundo a nuestro alrededor y adaptarnos a él’, señala el comunicado de la Academia de Ciencias de Suecia.

¿Cómo sentimos nuestro entorno? Los mecanismos que subyacen a los sentidos han estimulado nuestra curiosidad por miles de años: cómo detectan la luz nuestros ojos, cómo son percibidas las ondas sonoras por nuestros oídos, de qué manera los diferentes compuestos químicos interactúan con receptores en nuestra nariz o boca, generando los sentidos del olfato y el gusto. También tenemos otras formas de percibir el mundo que nos rodea. Imaginen estar caminando descalzos por un parque un día de verano, sintiendo el calor del sol y la brisa suave en el rostro, y las briznas de pasto bajo los pies. Estas percepciones de temperatura, tacto y movimiento son esenciales para nuestra adaptación a un entorno en constante cambio.

El filósofo René Descartes predijo en el siglo XVII la existencia de ‘hilos’ que conectan las diferentes partes de nuestra piel con el cerebro, informando a este último de la presencia de diversos estímulos. Varios siglos después, Joseph Erlanger y Herbert Gasser reciben el premio Nobel de fisiología y medicina en 1944 por el descubrimiento de neuronas sensitivas que reaccionan a diferentes tipos de estímulos dolorosos o no dolorosos. Así, fue posible identificar neuronas altamente especializadas para detectar y transmitir diversos tipos de estímulo, permitiéndonos, por ejemplo, sentir las diferencias de textura de las superficies usando la yema de los dedos, o discernir entre el calor agradable y el calor doloroso. Sin embargo, una gran pregunta persistía: ¿cómo se generan los impulsos nerviosos que permiten la percepción de la temperatura y la presión?

Hacia finales de los años 90, todavía no se comprendía cómo es que la capsaicina, el ingrediente activo del ají picante, interactuaba con las células del cuerpo para inducir la sensación de quemazón. Fue David Julius con su equipo quien asumió la titánica tarea de analizar una librería masiva de genes presentes en neuronas sensitivas, hasta que identificó en células en cultivo un gen que las hacía sensibles a la capsaicina. El receptor de membrana codificado por este gen y que actúa como canal iónico se denominó TRPV1, y los resultados fueron publicados en la revista Nature en 1997. De manera inesperada, Julius también notó que este receptor puede ser además activado por calor en rango doloroso. Este descubrimiento fue la puerta de entrada para el hallazgo de varios otros receptores sensibles a temperatura.

La familia de receptores TRP incluye hoy a veintiocho miembros, que se expresan en diferentes tipos celulares e intervienen en variedad de procesos, entre ellos visión, gusto, olfato, tacto, osmorregulación y detección de temperatura. Además, seis de estos receptores se expresan en neuronas sensitivas permitiendo la detección de estímulos térmicos, mecánicos y químicos, tanto inocuos como nocivos. Así cada TRP se activa frente a un cierto rango de temperatura y frente a ciertas sustancias químicas. Como ya se mencionó, el TRPV1 responde a temperaturas mayores a 43ºC (umbral de dolor por calor) y a capsaicina, vainilloide presente en pimientos picantes, siendo responsable de la sensación de ardor que este tipo de compuestos genera. Por su parte, el TRPM8 resulta sensible a temperaturas templadas/frías (entre 15 y 25ºC aproximadamente) y a sustancias refrescantes como el mentol y el eucaliptol. Finalmente, el TRPA1 responde a estímulos mecánicos, temperaturas menores a 18ºC y sustancias irritantes como ciertos componentes del humo de cigarrillo y del gas mostaza, siendo responsable de la sensación de ardor o irritación que estos compuestos generan en las vías aéreas.

Mientras esto ocurría, quedaba irresuelta otra incógnita: cómo son convertidos los estímulos mecánicos en sensaciones de tacto y presión. El tacto ha fascinado a filósofos y científicos por más de dos milenios. En tiempos de Aristóteles, el tacto y el gusto (en ese entonces considerado una modalidad de tacto) eran entendidos como sentidos inferiores, porque requerían el contacto directo y eran fácilmente corruptibles por nuestras necesidades carnales de reproducción y sustento. Por el contrario, la vista, la audición y el olfato permitían la acción a distancia, y por ello eran considerados sentidos de mayor jerarquía. Sin embargo, Aristóteles desarrolló una perspectiva diferente al relacionar nuestro poder de discriminación táctil con la inteligencia humana: ‘En los otros sentidos, el hombre es inferior a los animales, pero en el sentido del tacto, su agudeza es ampliamente superior; es por eso que el hombre es el más inteligente de los animales’. Dos milenios y algunos años más tarde, mediante el uso de un tipo celular que reacciona a la estimulación mecánica, Patapoutian y su equipo fueron inactivando, de a uno, 72 posibles candidatos hasta dar con un único gen cuyo silenciamiento convirtió a las células en insensibles al estímulo mecánico. Habían dado con un nuevo y desconocido receptor mecanosensible al que se denominó Piezo1, al que le seguiría muy pronto el receptor Piezo2, identificado por homología. Los resultados fueron publicados en la revista Science en 2010.

Con el tiempo, pudo determinarse que las proteínas Piezo representan una familia de canales iónicos capaces de responder directamente a fuerzas mecánicas deformantes que incluyen el tacto directo, la succión y el cizallamiento. Ambos canales se encuentran expresados en tejidos repletos de células mecanosensibles y son esenciales en el sentido del tacto, la propiocepción (percepción de la posición del cuerpo y el movimiento) y el dolor inducido por estímulos mecánicos. Sin embargo, el enriquecimiento del receptor Piezo2 en neuronas aferentes primarias (las proyecciones de estas neuronas constituyen los nervios sensitivos en nuestro cuerpo) lo posicionaron inmediatamente como un candidato en la transducción de señales táctiles. De hecho, en diversos estudios en el ratón se ha demostrado que la eliminación del receptor Piezo2 en estas neuronas causa la pérdida completa del sentido del tacto, que su activación induce dolor en ratones normales, y que su bloqueo en ratones con lesión de nervios periféricos (neuropatía) reduce el dolor crónico. Es relevante observar que pacientes con una mutación específica en el gen que codifica el receptor Piezo2 muestran carencia de sensibilización al dolor causado por estados inflamatorios.

Para comprender la trascendencia de los hallazgos de Julius y Patapoutian es necesario considerar que, en el hombre y los animales, el sistema somatosensorial involucra la capacidad de percibir el medio externo (exterocepción) y el interno (interocepción), y que con sus contribuciones estos investigadores han cambiado completamente el modo de entender la sensibilidad y el dolor, la percepción y la adaptación al mundo que nos rodea, conectando dos eventos aparentemente distantes como son el estímulo y el impulso nervioso generado. La información producida por el sistema exteroceptivo permite adaptaciones a modificaciones del medio ambiente y la prevención o respuesta defensiva ante estímulos eventualmente nocivos, en tanto que el sistema interoceptivo provee la información necesaria para el correcto control de la actividad contráctil muscular y la homeostasis de la tensión de la musculatura lisa visceral (información sensitiva crítica para la micción, la defecación y la regulación de la tensión arterial, entre otras acciones). Pero, además, la interocepción incluye la información proveniente de los huesos, las articulaciones y los músculos, denominada propiocepción, y que provee al organismo con la ‘sensación de sí mismo’ informando sobre la localización del cuerpo y los miembros en tiempo y espacio. Como tal, la propiocepción, también conocida como el ‘sexto sentido’, es crítica para el control de la postura, el control motor y la compensación de reflejos motores. Aunque las bases de la actividad motriz están bien establecidas, la contribución de la propiocepción es fundamental para el control fino de la secuencia de contracciones musculares y movimientos articulares requeridos para la locomoción y regulación de los movimientos de precisión.

Lo cierto es que el hecho de que los sentidos del tacto, la propiocepción, la temperatura y el dolor sean mediados por la misma maquinaria neuronal, pero por receptores de tan alta precisión, como son los canales iónicos descriptos, abre la posibilidad de nuevos ‘blancos moleculares terapéuticos’ para el tratamiento específico de patologías que lleven asociadas alteraciones de estas sensibilidades. Si bien todavía se está lejos de esta posibilidad, el camino abierto por Julius y Patapoutian es por demás estimulante y prometedor, y seguramente en el futuro veremos nuevos avances en esta dirección.

Pablo R Brumovsky, M Florencia Coronel y Marcelo J Villar

Instituto de Investigaciones en Medicina Traslacional-Conicet. Universidad Austral

FÍSICA

Un premio Nobel a la complejidad

Edward Lorenz se preguntó si no había cometido un error. No un error en alguna cuenta, sino una pésima elección profesional. Transcurría 1963. Lorenz (1917-2008), un matemático en el Massachusets Institute of Technology en Boston, había derivado un sistema simplificado para modelar la atmósfera. Ellen Fetter (n. en 1940) programó y realizó varias simulaciones en una computadora para estudiar la evolución de ese sistema. Y cada simulación arrojaba un resultado diferente. Varios colegas le habían advertido a Lorenz que no juegue con computadoras: no eran confiables, y los resultados que obtuviese no tendrían la fuerza general de un teorema. ¿Eran esas diferentes soluciones solo el resultado de la imperfección de las recientes computadoras? ¿Había perdido Lorenz y su equipo el tiempo con un problema irrelevante? El tiempo mostró que no, que efectivamente el sistema que derivó Lorenz tenía soluciones caóticas: pequeños cambios en las condiciones iniciales generaban grandes cambios en el estado final del sistema. Y de esta forma, unas pocas simulaciones en una computadora primitiva dieron inicio a dos grandes hitos de la física en los últimos sesenta años. Por un lado, la aparición del ‘efecto mariposa’ como excusa perfecta para escribir decenas de guiones de películas. Y, por otro, el nacimiento de la teoría de los sistemas complejos y una de sus más espectaculares aplicaciones: el estudio físico del clima.

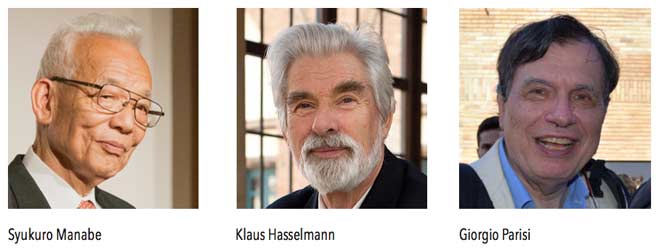

El Nobel de física 2021 premió avances importantes en el estudio de la física de los sistemas complejos, un área que comenzó a gestarse de la mano de Lorenz y otros pioneros en el estudio del caos, la dinámica de fluidos y la física atmosférica, y que desde allí se expandió hasta incluir aplicaciones en astrofísica, cosmología, física de sistemas biológicos, materia condensada y, más recientemente, en el estudio de la inteligencia artificial y problemas sociales y económicos. En particular, la academia sueca otorgó la mitad del premio al italiano Giorgio Parisi (n. en 1948) ‘por el descubrimiento de la interacción entre el desorden y las fluctuaciones en sistemas físicos desde la escala atómica hasta la planetaria’, y la mitad restante al japonés Syukuro Manabe (n. en 1931) y al alemán Klaus Hasselmann (n. en 1931) ‘por el modelado físico del clima de la Tierra, cuantificando la variabilidad y prediciendo de manera confiable el calentamiento global’.

Pero ¿qué son los sistemas complejos? Estamos acostumbrados a asociar la física a lo muy pequeño o a lo inmensamente grande. A las partículas subatómicas, o a las estrellas y las galaxias; a la mecánica cuántica, o a la astrofísica y la cosmología. Pero la mayoría de lo que nos rodea también forma parte del estudio de la física: el cambio de estado de la materia cuando el agua líquida se congela y se transforma en hielo, el cambio en ciertos materiales convirtiéndolos en imanes permanentes que usamos para fijar recordatorios a nuestras heladeras, la dinámica de sistemas biológicos o de epidemias, o el estado futuro de la atmósfera que buscamos ávidamente cada mañana al mirar el pronóstico del tiempo en el noticiero o nuestros celulares. Todos estos son sistemas con muchísimos componentes, y cuyo comportamiento es… complejo. Llamativamente, a pesar de lo cerca que tenemos estos ejemplos, los sistemas complejos resultan difíciles de comunicar para el público general. Porque, a diferencia de la física de los extremos, estos sistemas no involucran nuevas fuerzas, ni nuevas leyes fundamentales. Pero requieren nuevas técnicas, nuevas ideas, y mucho ingenio para comprenderlos.

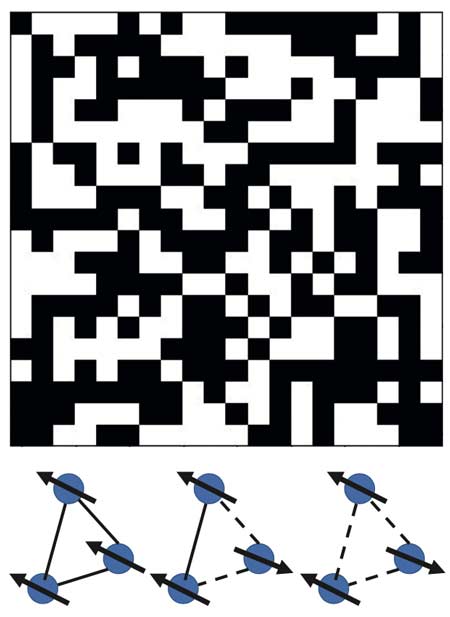

La física de la última mitad del siglo XX y del inicio del siglo XXI está marcada por la expansión de las fronteras hacia estos sistemas cada vez más complejos, pero también más realistas. Y esa expansión permitió una explosión de estudios interdisciplinarios en los límites entre la física y otras ciencias. Giorgio Parisi ha jugado un rol muy importante en el estudio de estos problemas. Uno de sus mayores aportes a la comprensión de los sistemas complejos tiene que ver con los vidrios de spin (ver figura), sistemas magnéticos desordenados y que requieren terapia: están frustrados. Podemos entenderlos con una analogía introducida por Marc Mezard, el mismo Parisi y el argentino Miguel Ángel Virasoro. Pensemos en tres personas, que pueden ser amigas o enemigas entre sí, y solo pueden tener dos opiniones. Si los tres son amigos, es fácil que estén alineados en sus ideas. Si dos son amigos y uno no, los dos amigos se alinearán, y el tercero se opondrá. Pero si los tres son enemigos, necesariamente dos deberán alinearse aun cuando no se quieran: el sistema está frustrado. Reemplacemos ahora los amigos por pequeños imancitos que pueden alinearse para un lado o el otro, y tenemos un modelo muy sencillo (¡pero complejo!) para lo que ocurre en muchos sistemas magnéticos amorfos. En dos trabajos publicados en 1979, Parisi identificó los vidrios de spin como un paradigma de los sistemas complejos en la naturaleza, y aisló algunas de sus propiedades más importantes: tienen muchos estados de equilibrio posibles, y es prácticamente imposible encontrar el estado de mayor equilibrio entre una miríada de estados ordenados en formas muy específicas. Estas ideas se pueden extender a otros sistemas complejos (como la turbulencia atmosférica, donde Parisi también hizo aportes). Y Parisi también jugó con la idea de que ciertos fenómenos muy lentos observados en el clima podrían estar asociados a una forma de amplificación del ruido que es característica de los sistemas complejos.

Esta discusión nos debería permitir identificar el vínculo (en principio no tan obvio) entre una y otra mitad del premio Nobel. La atmósfera es un sistema complejo muy sensible a pequeños cambios y con muchos estados posibles (de hecho, las simulaciones que se usan para estudiar el cambio climático se repiten varias veces, para encontrar, como en los vidrios de spin, los estados más probables). Y, como en el ejemplo de Lorenz, no alcanza con poder simular su evolución. La confianza se gana a partir de una comprensión profunda de lo que ocurre en la naturaleza, muchas veces usando lo que en física se llaman ‘modelos de juguete’: modelos simplificados que capturan propiedades esenciales del sistema complejo y que permiten verificar la validez de las simulaciones numéricas, o mejorar cómo se capturan procesos físicos fundamentales en dichas simulaciones.

La otra mitad del premio Nobel está entonces asociada a estas aplicaciones. Syukuro Manabe, climatólogo japonés radicado en Estados Unidos, se sorprendió al recibir el llamado del premio Nobel. La Academia Sueca destacó su rol en el desarrollo de un modelo muy sencillo para entender la convección (el movimiento de la atmósfera transportando aire caliente desde el suelo hacia las capas más altas, de la misma forma que el agua en una pava hierve para llevar el agua más caliente hacia arriba). El modelo de Manabe es tan sencillo que reduce la atmósfera a una sola línea: una atmósfera unidimensional. Pero ese modelo, publicado en 1967, permitió entender cómo el cambio en la concentración de dióxido de carbono resulta en un aumento drástico de la temperatura en las capas más bajas de la atmósfera. Y, a partir de ese resultado, la idea fue extendida por Manabe y sus colegas para realizar primero simulaciones climatológicas muy sencillas, y más tarde simulaciones masivas como las que hoy se usan regularmente para entender el cambio climático.

Klaus Hasselmann es un físico alemán que realizó su tesis en el estudio de la turbulencia. Desde ese tema se acercó al estudio de los procesos aleatorios y de la oceanografía. Ganó reputación estudiando la interacción no lineal de ondas en el océano, usando un método desarrollado originalmente por Richard Feynman (1918-1988) para estudiar la física de partículas fundamentales. Pero las contribuciones que le valieron el premio Nobel están nuevamente asociadas a los modelos sencillos para entender sistemas complejos. Uno de esos resultados, publicado en 1976, es un modelo que explica cómo la atmósfera o los océanos generan procesos en escalas de tiempo muy diferentes a partir de ruido, y el otro es un método publicado en 1993 para identificar qué parte de una serie de datos son ruido y qué parte de esos datos son relevantes para entender cómo evoluciona un sistema. Este último método es hoy central para separar las señales del cambio climático causadas por el hombre de las fluctuaciones al azar que tiene cualquier sistema físico extenso, lo que en la literatura del área y en los medios se describe como la ‘huella antropogénica’.

En 1966, pocos años después de que Edward Lorenz encontrase la frustración y la gloria profesional en forma simultánea, Richard Feynman escribió en un famoso libro de texto de física que es muy probable que ya contemos con las ecuaciones que describen el origen de la vida: las ecuaciones de la mecánica cuántica deberían poder describir este problema. Sin embargo, no contamos con una teoría que nos permita saber qué tipo de soluciones cualitativas pueden ser explicadas por una ecuación. Parafraseando a Feynman, no podemos decir si las ecuaciones de la física que hoy conocemos permiten explicar la existencia en el universo de ranas, de compositores musicales, o de la moralidad. En su libro, Feynman sugiere que uno de los futuros desafíos de la física debería ser construir una teoría que nos permita identificar qué tipo de soluciones pueden ser generadas por una teoría. La física de los sistemas complejos es un intento por responder a ese desafío, y por obtener información cualitativa sobre las configuraciones que son físicamente posibles en sistemas extensos. Hoy, la teoría de los sistemas complejos no solo se usa para entender el magnetismo de sistemas amorfos, la dinámica de fluidos, o el cambio climático. Sus aplicaciones se han ampliado para también incluir la física de sistemas biológicos, problemas sociales y de modelado del mercado bursátil, problemas de inteligencia artificial y redes neuronales, y muchos problemas más. Por todo esto, la física de los sistemas complejos ha recibido finalmente un premio Nobel. Pero queda un largo camino por recorrer. Larga vida a los sistemas complejos.

El autor agradece a Gabriel Mindlin por las estimulantes discusiones sobre estos problemas desde que se anunció el premio Nobel de física 2021, y desde mucho antes.

LECTURAS SUGERIDAS

BENZI, R, PALADIN G, PARISI G y VULPIANI, A, 1984, ‘On the multifractal nature of fully developed turbulence and chaotic systems’, Journal of Physics, A 17: 3521.

HASSELMANN, K, 1976, ‘Stochastic climate models part I. Theory’, Tellus, 28: 473.

HASSELMANN, K, 1993, ‘Optimal fingerprints for the detection of time-dependent climate change’, Journal of Climate, 6: 1957.

LORENZ, EN, 1963, ‘Deterministic nonperiodic flow’, Journal of the Atmospheric Sciences, 20: 130.

MANABE, S & WETHERALD, RT, 1967, ‘Thermal equilibrium of the atmosphere with a given distribution of relative humidity’, Journal of the Atmospheric Sciences, 24: 241.

MANABE, S & WETHERALD, RT, 1975, ‘The effects of doubling the CO2 concentration on the climate of a general circulation model’, Journal of the Atmospheric Sciences, 32: 3.

PARISI, G, 1979, ‘Infinite number of order parameters for spin-glasses’, Physical Review Letters, 43: 1754.

PARISI, G, 2006, ‘Spin glasses and fragile glasses: Statics, dynamics, and complexity’, Proceedings of the National Academy of Sciences, 103: 7948.

Pablo Daniel Mininni

UBA-Conicet

QUÍMICA

Organocatálisis asimétrica: una herramienta verde que revoluciona la construcción de moléculas

Todo a nuestro alrededor está rodeado de moléculas: los polímeros en nuestras ropas u objetos plásticos, la diversidad de medicamentos que nos ayudan en nuestra salud (y permitieron que nuestra expectativa de vida aumentara considerablemente en los últimos años), los agroquímicos que hicieron posible la fabricación de más y mejores alimentos (permitiendo abastecer a una población mundial cada vez mayor). Para construir alguna determinada molécula de importancia son necesarios procesos fáciles, que consuman poca energía y pocos reactivos químicos, y que cada paso de construcción sea efectivo y genere el menor impacto posible para el medio ambiente. Es claro que los avances en nuestra calidad de vida a veces entran en conflicto con el medio ambiente, y encontrar procesos más amigables es sumamente importante. En ese sentido, las herramientas con las que cuentan los químicos para construir moléculas son limitadas y se encuentran en continuo desarrollo.

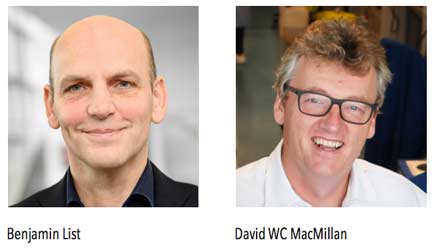

Este año, la Real Academia Sueca de Ciencias distinguió con el premio Nobel en química a dos científicos: Benjamin List (director del Instituto Max Planck de Investigación del Carbón, Alemania) y David WC MacMillan (profesor de la Universidad de Princeton, Estados Unidos), ‘por el desarrollo de la organocatálisis asimétrica’. Es un premio que involucra netamente a la química orgánica, la que en sus comienzos intentaba entender la química de la vida y luego, con el devenir del tiempo, se convirtió en la química de las moléculas que contienen carbono.

Estos científicos descubrieron, independientemente, maneras fáciles y precisas de construir moléculas. Este reconocimiento es para dos personas que han contribuido a ampliar el abanico de posibilidades con las que se pueden hacer estas transformaciones, utilizando como herramientas moléculas sencillas que provienen de la naturaleza. La organocatálisis asimétrica ha revolucionado la manera de ver la química: es como descubrir otro tipo de ladrillos, ecológicamente más verdes y que permiten la construcción de moléculas asimétricas de manera más simple y conveniente.

Entonces, ¿qué es la organocatálisis asimétrica? Lo primero que necesitamos saber es qué es un catalizador.

¿Qué es un catalizador?

Para construir moléculas, se necesita unir átomos de manera precisa, construir enlaces con arreglos específicos, es decir, hacer reacciones químicas. Esto es una tarea difícil. Las reacciones químicas son generalmente lentas. Por este motivo necesitamos sustancias que aceleren y controlen las reacciones químicas (las etapas de construcción de una molécula) y que no se consuman en el proceso, denominadas catalizadores. Por ejemplo, el agua oxigenada (H2O2, peróxido de hidrógeno) se descompone muy lentamente en oxígeno y agua, por eso la podemos tener en nuestro botiquín por un largo tiempo. Un catalizador muy conocido desde el siglo XIX es la plata metálica, que en contacto con agua oxigenada acelera la producción de oxígeno y agua, pero a la plata no le pasa nada, porque es un catalizador. Los catalizadores no solo se usan en el laboratorio: los que encontramos en los autos se componen de metales tales como platino, paladio y rodio, y transforman las emisiones contaminantes (monóxido de carbono, hidrocarburos no quemados) en moléculas menos tóxicas (agua, dióxido de carbono). La catálisis es fundamental en la industria para la conversión de materia prima en moléculas importantes, de alto valor agregado como agroquímicos y fármacos. Se estima que el 35% del producto bruto interno del planeta está relacionado o involucra catálisis química, lo que da idea de su importancia.

Biocatalizadores y catalizadores metálicos

Hasta el descubrimiento de los organocatalizadores en el año 2000, los catalizadores se dividían en dos grupos: los biocatalizadores (entre ellos las enzimas, proteínas compuestas por aminoácidos) y los catalizadores con un centro metálico. Estos últimos, si bien son poderosas herramientas para la construcción de moléculas, presentan varias desventajas. El metal en el catalizador puede ser tóxico, lo que conlleva purificaciones más complejas de las moléculas para las que se utiliza esa sustancia, conduciendo a procesos más costosos y menos amigables para el ambiente. También algunos de estos catalizadores son sensibles a la humedad o al aire, lo que dificulta su uso, sobre todo a escala industrial.

Biocatalizadores y asimetría

Los otros catalizadores son las enzimas, moléculas muy grandes y complejas presentes en cualquier organismo vivo. Distintas enzimas ayudan a que se construyan moléculas necesarias para mantener el ciclo de vida. Estos biocatalizadores tienen la capacidad de construir moléculas de manera asimétrica, es decir, con una disposición espacial determinada. Pero ¿qué es una molécula asimétrica o quiral? Si una molécula se refleja en un espejo y su imagen especular no se puede superponer con esa molécula, se dice que es asimétrica o quiral. Esa molécula y su imagen especular son enantiómeros. Como ejemplo en la vida cotidiana, pensemos en la mano derecha, cuya imagen en el espejo es la mano izquierda; sin embargo, nuestras dos manos no las podemos superponer; de hecho, nuestros pulgares quedan de lados opuestos. En la naturaleza, la asimetría es muy importante, ya que las funciones biológicas de los enantiómeros pueden ser muy distintas. Un caso muy interesante de molécula asimétrica es el limoneno: un enantiómero tiene aroma a naranja, y su imagen especular tiene aroma a limón. Nuestro olfato puede diferenciar los dos enantiómeros, es decir, diferencia la disposición espacial que poseen esas dos moléculas a través de su unión a receptores específicos. Lo mismo ocurre con los fármacos, donde, en ciertos casos y para una actividad particular, se requiere construirlos de manera asimétrica, o sea, sintetizar un único enantiómero.

List, la prolina y un resultado revolucionario

La naturaleza construye las moléculas de manera asimétrica a través de las enzimas muy eficientemente. En ese sentido, el alemán Benjamin List (n. 1968), formado como químico orgánico que construye (sintetiza) moléculas, se había incorporado al grupo de Carlos F Barbas (1964-2014) de The Scripps Research Institute, San Diego, California, donde se investigaban anticuerpos catalíticos. Pensando en cómo funcionan las enzimas, entendiendo que algunas de ellas no necesitan metales y que las enzimas están compuestas por aminoácidos, List tuvo una idea sencilla y transformadora: ¿y si unos pocos aminoácidos pudieran catalizar una reacción? Su investigación demostró que una molécula pequeña como la prolina, un único aminoácido, podía hacer el mismo trabajo. En este caso podía actuar como catalizador asimétrico en una reacción que construye enlaces uniendo átomos de carbono, llamada reacción aldólica. La prolina se había utilizado como catalizador en los años 70, pero el estudio no se continuó. Fue la inspiración, racionalización e investigación de un proceso que condujo a este hallazgo. La prolina tiene una disposición de átomos particular, tridimensional, y un átomo de nitrógeno que permite acomodar otras dos moléculas y unirlas, oficiando de catalizador asimétrico. Esa idea fue transformadora, porque a partir de ese momento comenzó la investigación del enorme potencial que tiene esta pequeña y simple molécula, barata, accesible, que además es un producto natural no tóxico. List se dio cuenta en 2000 de las grandes posibilidades que tenía este concepto, ya que se podrían diseñar catalizadores para la construcción de enlaces de otro tipo en las moléculas.

MacMillan define el término ‘organocatálisis’

Por otra parte, y paralelamente, el escocés David MacMillan (n. 1968) había realizado su posdoctorado en Harvard trabajando en catálisis asimétrica utilizando metales. En 1998 se muda a la Universidad de California-Berkeley, ya pensando que los catalizadores metálicos eran costosos, difíciles de manejar y por ende difíciles de ser utilizados a escala industrial. Comenzó a diseñar catalizadores que fueran moléculas orgánicas sencillas, que pudieran participar en la construcción de enlaces y, para ello, su estrategia consistió en utilizar una unión débil que fuera transitoria y breve. Ese catalizador debería estar unido momentáneamente (por una unión ‘iminio’) y debería contener nitrógeno. Evaluó su hipótesis con una reacción muy importante, la reacción de Diels-Alder (que es, además, una reacción muy lenta). Pudo construir una molécula de manera asimétrica, una sola imagen especular, utilizando como catalizador una molécula asimétrica pequeña y sencilla diseñada por él. En ese momento se dio cuenta de que este hecho era muy importante y acuñó el término ‘organocatálisis’. Pudo prever que se podrían descubrir otras reacciones diferentes utilizando estrategias de diseño y, de alguna manera, transferir la estructura tridimensional del organocatalizador diseñado a la nueva molécula construida.

De manera independiente, tanto List como MacMillan descubrieron y desarrollaron el concepto de organocatálisis. A través de los años, se han diseñado organocatalizadores estables y baratos para una variedad de construcciones de enlaces y moléculas. Es una nueva herramienta poderosa que hace rever y repensar los procesos de la construcción de moléculas, permitiendo la construcción de moléculas en varios pasos a la vez (reacciones en cascada), abaratando los procesos y reduciendo los desperdicios. Como evidencia de la simplicidad y elegancia de la organocatálisis, basta ver el ejemplo de la construcción de la estricnina, que es un producto natural muy complejo y sirve de modelo para probar el avance de las herramientas de construcción de moléculas. En 1958 su síntesis conllevó 29 pasos de construcción, mientras que en 2012 y por organocatálisis requirió tan solo 12, y además fue 7000 veces más eficiente.

La organocatálisis y su gran impacto en la producción de fármacos

La organocatálisis es importante en la producción de productos farmacéuticos, puesto que generalmente una imagen especular es la activa y la otra no (o, peor, puede provocar efectos adversos). Antes de la catálisis asimétrica, muchos productos farmacéuticos se construían conteniendo ambas imágenes especulares y estas moléculas eran muy difíciles de separar. Para ver la importancia de construir una sola imagen especular, basta analizar el desastre que produjo la talidomida en los años 60. Este medicamento se usaba para combatir las náuseas en los primeros meses de embarazo, y una de las imágenes especulares de la talidomida fue la causante de serias deformidades en embriones. La organocatálisis proporciona métodos para sintetizar una sola imagen especular, una molécula asimétrica, y puede ser trasladada a grandes cantidades de manera simple. Por ejemplo, el agente antiviral oseltamivir contra el virus de la gripe se sintetiza en 5 pasos de reacción mediante organocátalisis y anteriormente requería 12 pasos. El proceso es actualmente más ‘verde’, menos perjudicial para el medio ambiente.

Resumiendo, la organocatálisis es una herramienta poderosa, elegante y práctica, que permite construir moléculas de manera precisa y con procesos de menor impacto ambiental. Este es el gran desafío de nuestro tiempo, que nuestra calidad de vida impacte lo menos posible sobre nuestro planeta. Los químicos ahora poseen estas herramientas para ayudar en esta transformación y, así, generar una diferencia.

En 2019, la comunidad de químicos orgánicos de nuestro país tuvo el honor de recibir a List en calidad de conferencista en el XXII Simposio Nacional de Química Orgánica, y fue designado socio honorario de la Sociedad Argentina de Investigación en Química Orgánica.

LECTURAS SUGERIDAS

LIST, B (ed.), 2007, ‘Organocatalysis’, Chemical Reviews, 107, 12: 5413-5883.

MACMILLAN, DWC, 2008, ‘The advent and development of organocatalysis’, Nature, 455: 304–308.

REAL ACADEMIA SUECA DE CIENCIAS, 2021, ‘Their tools revolutionised the construction of molecules’. https://www.nobelprize.org/uploads/2021/10/popular-chemistryprize2021.pdf

Carola Gallo

Departamento de Química Orgánica, FCEyN-UBA.

CIHIDECAR-Conicet-UBA

ECONOMÍA

Contribuciones metodológicas para la inferencia causal

Este año, el premio en ciencias económicas instituido por el Banco de Suecia en memoria de Alfred Nobel lo recibió un trío conformado por Joshua Angrist del Massachusetts Institute of Tecnology (MIT), David Card de UC Berkeley y Guido Imbens de Stanford University. Dicho galardón fue otorgado por la contribución empírica de David Card a la economía laboral y, para el caso de Angrist y Imbens, por su contribución al análisis de las relaciones causales en economía. Las contribuciones de los investigadores revolucionaron la forma en la que se realizaba el trabajo empírico en economía, en donde resulta más difícil realizar experimentos controlados de la manera que se realizan en las ciencias médicas.1

Los investigadores estudiaron lo que se conoce como ‘experimentos naturales’, en donde como consecuencia de situaciones aleatorias o cambios de política específicos causa que distintos grupos de personas –pero pueden ser también empresas, regiones, comunidades– se ven afectadas de manera diferencial por algún fenómeno económico de interés, como, por ejemplo, cambio en la legislación del salario mínimo u obligatoriedad de los años de educación de acuerdo con la fecha de nacimiento, entre otros.

Los investigadores permitieron echar luz sobre fenómenos que son relevantes para la economía y se discuten constantemente tanto en países en desarrollo como en los países de altos ingresos. Permiten responder preguntas tales como ¿qué efectos tiene la migración sobre los salarios de los nativos?, ¿cuál es la relación entre el salario mínimo y el nivel de empleo?, ¿cuánto paga el mercado por un año adicional de educación?, ¿existe o no un efecto sobre los salarios de haber estado en el ejército?

Estas cuestiones son de difícil respuesta ante la imposibilidad de realizar un ‘experimento’, debido a los que se conoce como ‘sesgo de variables omitidas’, esto es, el resultado de interés –ingresos, empleo, etc.– y la variable de política (salario mínimo, migración, educación) están ambas correlacionadas con variables no observables. Entre otros, las personas que tienen más educación también tienen salarios más altos por factores tales como mayor inteligencia, entre otras. Dicha variable afecta conjuntamente a la cantidad de educación que el individuo adquiere y a los ingresos que recibirán en el mercado laboral. Es por ello que los llamados experimentos naturales permiten estimar estos efectos causales. Para el caso de medir el efecto de haber participado en el ejército durante los salarios posteriores en el mercado laboral, Angrist (1990) estudia las loterías que se llevaron a cabo durante la guerra de Vietnam, en donde la decisión de participar dependía del resultado de la lotería y no exclusivamente de preferencias individuales2. Angrist encuentra que durante los años 80 –ya varios años luego de finalizada la guerra– los veteranos blancos ganan 15% menos que los no veteranos. El efecto desaparece para los afroamericanos.

Card (1990), estudia el efecto del llamado ‘éxodo de Mariel’, que permitió la salida de Cuba de gente que deseaba emigrar, sobre el mercado laboral de Miami. Los recién llegados a Miami generaron un aumento del 7% en la oferta laboral para sectores menos calificados. Dicho aumento tuvo un efecto casi nulo sobre los salarios de los trabajadores con baja calificación, incluidos los mismos migrantes. Dicho efecto se explica en parte por la alta capacidad del mercado laboral de Miami para absorber trabajadores inmigrantes, como lo había hecho con inmigrantes que llegaron durante las dos décadas anteriores al ‘éxodo de Mariel’.

Por su parte, Imbens tiene un sinnúmero de contribuciones a las herramientas econométricas metodológicas para poder estimar efectos causales.

El uso de experimentos naturales no está libre de críticas por algunas de sus limitaciones y supuestos. Muchos de ellos se parecen a las objeciones que se les hacen a los experimentos aleatorizados controlados. Entre ellos podemos destacar dos.

La primera tiene que ver con lo que se conoce como el criterio de ‘validez externa’, que sostiene que los resultados de un experimento natural solo son válidos para el caso específico en cuestión. Esto no solo es válido para los experimentos naturales, sino para todo estudio empírico en donde la representatividad de la población estudiada sea distinta respecto de la cual se quieren extrapolar las conclusiones.

La segunda tiene que ver con que la mayor parte de los experimentos arrojan resultados sobre lo que se denomina equilibrio parcial. Estos difieren de los que se obtendrían si el programa o fenómeno en cuestión se aplicara en una mayor escala.

Ambas críticas no invalidan las importantes contribuciones de los galardonados en términos de permitir un gran aporte al desarrollo de las herramientas empíricas para entender fenómenos complejos dentro de las ciencias sociales.

NOTAS

1. El premio el Banco de Suecia en memoria de Alfred Nobel de 2019 fue otorgado a investigadores que usan experimentos aleatorios controlados para aliviar la pobreza.

2. Investigadores argentinos (2011) también usaron la característica del sorteo para el servicio militar que regía en Argentina y los efectos sobre la actividad criminal.

LECTURAS SUGERIDAS

ANGRIST JD, 1990, ‘Lifetime Earnings and the Vietnam Era Draft Lottery: Evidence from Social Security Administrative Records’, The American Economic Review, 80, 3: 313-336.

CARD D, 1990, ‘The Impact of the Mariel Boatlift on the Miami Labor Market’, Industrial and Labor Relations Review, 43, 2: 245-257.

GALIANI S, ROSSI MA y SCHARGRODSKY E, 2011, ‘Conscription and Crime: Evidence from the Argentine Draft Lottery’, American Economic Journal: Applied Economics, 3, 2: 119-136.

María Laura Alzua,

Centro de Estudios Distributivos, Laborales y Sociales (UNLP) y Partnership for Economic Policy (PEP)

Doctor en ciencias biomédicas. Universidad Austral.

Doctor en medicina. Instituto Karolinska.

Investigador independiente, IIMT-Conicet.