¿Cuáles son las contribuciones al conocimiento realizadas por los ganadores de premios que, a lo largo de más de un siglo, se convirtieron en uno de los mejores mecanismos del mundo para identificar avances cruciales de las ciencias?

FISIOLOGÍA O MEDICINA

El premio Nobel de medicina o fisiología 2022 fue otorgado al biólogo sueco Svante Pääbo por sus descubrimientos sobre los genomas de homininos extinguidos y la evolución humana. Pääbo fundó y aún trabaja en el Instituto Max Plank de Antropología Evolutiva de Alemania, situado en la ciudad de Leipzig, la ciudad donde brilló Bach en las tres últimas décadas de su vida. Varios aspectos hacen destacable el reconocimiento a Pääbo dentro del panorama de los premios Nobel. En primer lugar, este año se concedió el premio a una sola persona, cuando la Academia Sueca últimamente venía premiando a dos o tres investigadores por disciplina. En segundo lugar, Pääbo es una personalidad ampliamente conocida, no solo en el mundo científico sino en los amplios sectores de la sociedad ligados a la cultura. Prueba de ello es quizá haber recibido en 2018 el premio Princesa de Asturias, el máximo galardón otorgado en España, y el hecho de que su charla TED tenga más de un millón y medio de visitas. En tercer lugar, si bien algunos de los resultados de Pääbo están relacionados indirectamente con la salud, la Academia Sueca ha tenido la bienvenida osadía de premiar hallazgos relacionados con la evolución y el origen de nuestra especie, un tema no explícitamente incluido entre los que califican para los Nobel. En efecto, los aportes de biólogos evolucionistas o antropólogos no han sido particularmente reconocidos por el Nobel en el pasado y uno se pregunta si, de haber vivido en el siglo XX, Charles Darwin lo habría obtenido. Por último, se considera a Pääbo el fundador del nuevo campo de la paleogenómica el cual, a través de la secuenciación masiva del ADN de organismos extinguidos, permite descifrar relaciones evolutivas y vías de poblamiento y migración tanto de ellos como de sus descendientes vivos.

De las momias egipcias al hombre de Neandertal

Al comienzo de su carrera, según cuenta en su autobiografía, Svante Pääbo estaba interesado en conocer la secuencia del ADN de momias humanas egipcias, cosa que logró técnicamente para pequeños fragmentos de su genoma pero que no tuvo mayor impacto científico. Más allá del impulso de su pasión juvenil por la egiptología, poca es la información relevante que podría haberse obtenido de individuos muertos hace solo 5000 años, que eran como nosotros Homo sapiens y tenían prácticamente la misma secuencia de ADN que nosotros. El cambio de paradigma ocurrió cuando se propuso secuenciar el ADN de restos fósiles del hombre de Neandertal, es decir, las especie Homo neanderthalensis. Se sabía que Neandertal se había extinguido hace unos 30.000 a 40.000 años y que la única especie del género Homo que sobrevivió y puebla aún la Tierra es Homo sapiens. No obstante, solo con evidencia paleontológica anatómica y sin evidencia genética era imposible saber la relación de parentesco entre H. neanderthalensis y H. sapiens. En un trabajo seminal publicado en la revista Cell en 1997, el grupo de Pääbo informó la secuencia completa del ADN de las mitocondrias obtenido de un hueso fósil de un ejemplar de Neandertal del valle de Neander (el sitio de Alemania donde se encontraron los primeros restos y que le dio el nombre a la especie). El artículo ilustró la tapa del número de la revista con una foto inmensa de una calota de Neandertal y el epígrafe ‘Los neandertales no son nuestros ancestros’. Las mitocondrias de las células tienen un genoma 200.000 veces más pequeño que el genoma de los núcleos y, como hay centenares de mitocondrias por células, resulta mucho más fácil obtener ADN en buen estado de un individuo muerto hace 40.000 años, es decir no degradado, de sus mitocondrias que del núcleo. Aun así, el logro de Pääbo fue un hito de la biología y permitió comprobar que la secuencia de ese ADN mitocondrial distaba tanto de las secuencias de los ADN mitocondriales de varias etnias de los humanos modernos, que le permitió concluir que H. sapiens no desciende en forma directa, diríamos vertical, de H. neanderthalensis.

Contaminaciones y canibalismo

El problema central de los experimentos de secuenciación de ADN antiguo (ancient DNA) son las posibles contaminaciones en la preparación del material biológico. Las más frecuentes provienen del ADN de las manos de los propios operadores que preparan la muestra y, adicionalmente, de bacterias u hongos que contaminan el trozo de hueso a triturar. El laboratorio de Pääbo dedicó años a perfeccionar su tecnología de modo de disminuir el riesgo de contaminación y reconocerla y descartarla en caso de que se produjera. De hecho, fue provechoso que el Rheinisches Landesmuseum de Bonn tardara meses en responder positivamente a la solicitud de Pääbo de utilizar un trozo del húmero de Neandertal de su colección ya que le permitió al laboratorio ajustar las técnicas de extracción de ADN de modo de minimizar las contaminaciones. Paradójicamente, si el museo hubiera accedido de inmediato, quizá se habrían publicado secuencias de H. sapiens creyendo que eran de Neandertal. Desde ese paper fundamental de 1997, Pääbo ha analizado ADN de decenas de restos de neandertales de Europa y Asia occidental. Lo más interesante es que descubrió que las mejores preparaciones de ADN provenían de huesos cuyos tejidos blandos habían sido removidos poco después de la muerte del individuo mediante prácticas de canibalismo, según se evidencia por marcas con instrumentos cortantes. Al no haber tejidos blandos susceptibles de putrefacción, la contaminación bacteriana de las muestras es mínima.

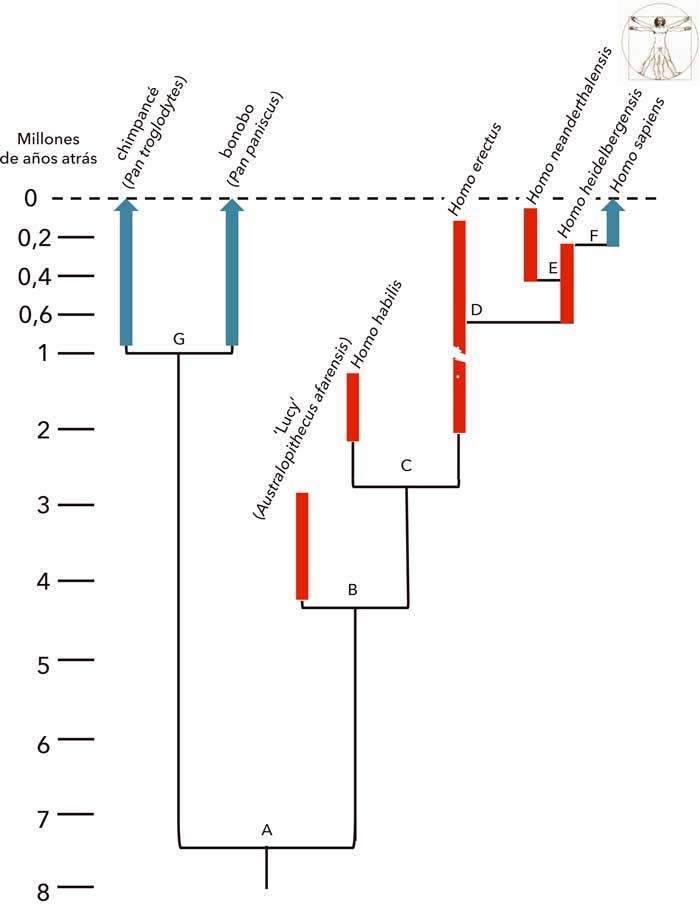

Línea de tiempo

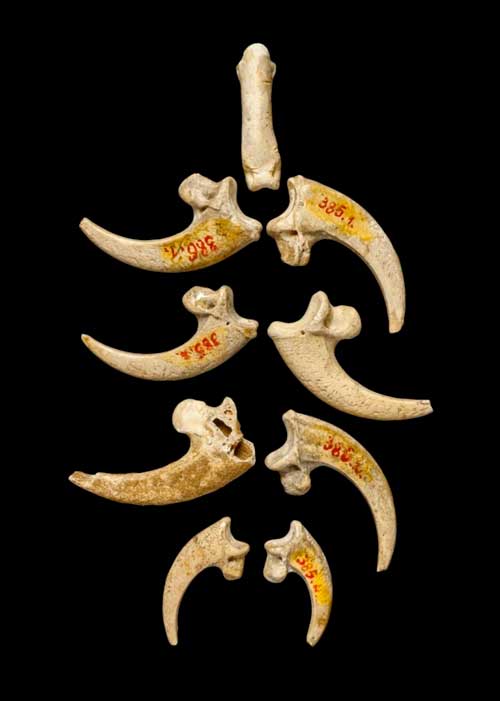

Para entender la evolución humana quizá valga la pena repasar someramente hitos en la evolución de la vida sobre la Tierra. Las primeras células vivas, del tipo de las bacterias, datan de hace 3800 millones de años (MA); las primeras células con núcleo, de hace 2.500MA; los primeros vertebrados, de hace 500MA; los primeros mamíferos, de hace 220MA, y los primeros primates (lémures, monos con cola y monos sin cola o simios –orangután, gorila, chimpancé, bonobo y ser humano–), de hace 65MA. Nuestro primo vivo genéticamente más cercano es el chimpancé. El ancestro común entre los chimpancés y los homínidos data de hace 7,5MA (figura 1.A). La rama de los homínidos, generada en África, tuvo muchas especies, todas extinguidas a distintos tiempos, como Australpithecus afaernsis, H. habilis, H. erectus, H. heidelbergensis y H. neanderthalensis. La figura 1 muestra que la única que sobrevivió hasta el presente es H. sapiens. Pese a su nombre germano, H. heidelbergensis se originó en África hace unos 600.000 años y se extinguió hace unos 200.000 años. En algún momento de su existencia, un grupo de H. heidelbergensis colonizó Europa y, hace unos 400.000 años dio origen a H. neanderthalensis. Las poblaciones de H. heidelbergensis que se quedaron en África dieron origen a H. sapiens hace unos 200.000 años, probablemente en la zona de la actual Etiopía. Sí, ¡los neandertales son europeos y nosotros somos africanos! Se piensa que hace aproximadamente 50.000 años un grupo de H. sapiens migró de África a Europa por el Sinaí. Hasta ese momento H. sapiens había colonizado toda África, principalmente sus costas, donde se alimentaba de bivalvos, y ‘no sabía’ que otra especie de ‘humanos’, los neandertales, era la dueña de Europa. Ambas especies habían desarrollado cultura, enterraban a sus muertos, manejaban el fuego, fabricaban un tipo de herramientas de piedra que evidencia pensamiento proyectivo y tenían pensamiento simbólico, tal cual lo revela el collar que neandertales fabricaron con talones de águila, descubierto en 2015 (figura 2).

Sexo entre especies

El siguiente hito mayor de Pääbo fue lograr secuenciar el genoma nuclear completo de Neandertal. Esto le permitió confirmar que los humanos que colonizaron Europa, Asia, Oceanía y finalmente América poseen en su genoma porciones del genoma de Neandertal. Los porcentajes varían entre el 0,5 y el 2,5% y revelan que hubo intercambio sexual de los H. sapiens que salieron de África hace 50.000-60.000 años con los neandertales, presumiblemente en Palestina. Indudablemente el primer híbrido entre las dos especies tendría 50% de sapiens y 50% de neandertal, pero nada sabemos de si la viabilidad de los híbridos dependía de si la cruza era macho sapiens con hembra neandertal o viceversa. Solo sabemos que los neandertales desaparecieron y asumimos que los híbridos fueron cruzándose preferencialmente con sapiens de modo que con el tiempo la proporción del genoma de neandertal en los humanos modernos fue disminuyendo hasta los valores actuales. Lo más importante es que los sapiens que no abandonaron África, y que hoy son mayormente negros del África subsahariana, no tienen segmentos de neandertal en sus genomas. Es decir, la pretendida ‘raza pura’ de los nazis no son los sajones ni los arios, cuyos ancestros se cruzaron con una especie arcaica, sino los negros del África. Esto confirma que el racismo no tiene bases biológicas sino políticas.

Una nueva especie de humanos arcaicos

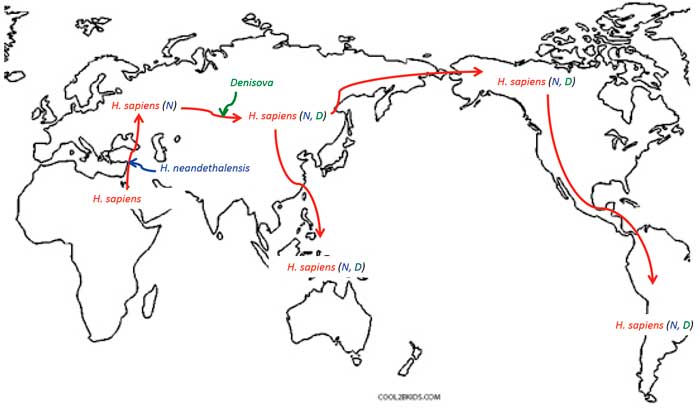

El tercer hito de Pääbo fue descubrir una nueva especie de humanos arcaicos en una cueva de los montes Altái de Siberia. La cueva de Denisova había sido habitada en distintas épocas por neandertales y por H. sapiens pero, al analizar la secuencia de ADN de una falange de un homínido de sexo femenino perteneciente a un grupo que había dejado África antes que los ancestros de los neandertales, Pääbo reveló que esta especie era diferente tanto de los neandertales como de sapiens, pero que segmentos de esta nueva especie, llamada Denisova, se hallaban en genomas de neandertales y de humanos modernos, lo cual implicaba cruzamientos con ambos. Lo más notable es que las secuencias de Denisova eran detectables, hasta en el 6% del genoma, en humanos modernos del este de Asia, el Sureste asiático, Oceanía… y América, pero estaban ausentes en europeos modernos y, por supuesto, en africanos subsaharianos. Estos hallazgos permitieron elaborar un mapa de las migraciones y poblamiento de nuestro planeta por H. sapiens (figura 3) de una manera mucho más precisa (y fascinante) que la proporcionada anteriormente por datos antropológicos, físicos y arqueológicos.

Por si quedaran dudas de las evidencias de cruzamientos entre y con humanos arcaicos, en 2018 Pääbo secuenció el genoma de restos de una joven que es primera generación híbrida entre neandertales y denisovanos, más precisamente, hija de una madre neandertal y un padre denisovano. Este espectacular hallazgo abre la posibilidad de que algún día se detecten los restos de una primera generación híbrida entre sapiens y neandertales, pero ya sabemos dónde sería más adecuado buscarla: en la ruta del Sinaí y de Palestina que siguieron nuestros ancestros al salir de África.

La influencia de Neandertal

No está muy claro si los segmentos de Neandertal confieren características positivas, negativas o neutras a los humanos que las poseen. En principio, el hecho de que estas secuencias hubieran sobrevivido reducidas a un bajo porcentaje del genoma y localizadas en regiones del ADN que están alejadas de los genes que codifican proteínas –los que representan el 30% del genoma– hace suponer que fueron siendo eliminadas por tóxicas. Hay evidencias preliminares que asignan a algunos de estos segmentos funciones en la adaptación de los humanos a nuevos ambientes y en la susceptibilidad a enfermedades. Más recientemente Pääbo encontró que una secuencia heredada de neandertales confiere a quienes la poseen mayor riesgo de padecer COVID-19 severo que quienes no la poseen. No sabemos si esto explica la baja incidencia de COVID-19 severo en la población africana.

Apreciación personal

No conozco a Pääbo personalmente ni tuve el privilegio de presenciar alguna de sus conferencias; no obstante, es sin duda mi mayor ídolo científico a quien admiro por sus descubrimientos que iluminaron, como pocos, la comprensión de nuestro paso por este planeta. Su historia de vida, que él ha hecho pública, además me produce empatía. Pääbo es hijo extramatrimonial de un científico que ganó también el premio Nobel: Sune Bergstrom fue galardonado en 1982 por sus trabajos sobre prostaglandinas. La madre es la química estonia Karin Pääbo y, como se aprecia, Svante lleva, significativamente, el apellido de su madre.

LECTURAS SUGERIDAS

GREEN RE et al., 2010, ‘A draft sequence of the Neandertal genome’, Science, 328: 710-722.

KRAUSE J et al., 2010, ‘The complete mitochondrial DNA genome of an unknown hominin from southern Siberia’, Nature, 464: 894-897.

KRINGS M et al., 1997, ‘Neandertal DNA sequences and the origin of modern humans’, Cell, 90: 19-30.

PÄÄBO S, 2014, ‘Neanderthal man’, en In search of Lost Genomes, Basic Books, Nueva York.

RADOVČIĆ D et al., 2015, ‘Evidence for Neandertal jewelry: Modified white-tailed eagle claws at Krapina’, PLoS One, 10: e0119802.

SLON V et al., 2018, ‘The genome of the offspring of a Neanderthal mother and a Denisovan father’, Nature, 561: 113-116.

ZEBERG H y S PÄÄBO, 2020, ‘The major genetic risk factor for severe COVID-19 is inherited from Neanderthals’, Nature, 587: 610-612.

Alberto R Kornblihtt

Biólogo y doctor en ciencias químicas, UBA.

Profesor emérito, FCEN, UBA.

Investigador superior contratado, Conicet.

[email protected]

FÍSICA

Informática cuántica y entrelazamiento

La mecánica cuántica ha dado lugar al descubrimiento de una variedad de fenómenos que resultan difíciles de conciliar con nuestra intuición sobre el funcionamiento del mundo. El entrelazamiento es, tal vez, uno de los más inquietantes. Tan inquietante, que hasta fue considerado una posible falla en la teoría. Los tres galardonados con el premio Nobel de física 2022 lograron demostrar que, de hecho, la naturaleza tiene aspectos antiintuitivos que nos obligan a abandonar la idea de un universo local y realista. Alain Aspect (Francia), John F Clauser (Estados Unidos) y Anton Zeilinger (Austria) comparten el premio por sus ‘experimentos con fotones entrelazados, estableciendo la violación de las desigualdades de Bell y siendo pioneros en la ciencia de la información cuántica’.

La primera revolución cuántica, que se desató a principios del siglo XX, sentó las bases tecnológicas para el desarrollo de la tecnología moderna. El láser, los transistores y circuitos integrados, la nanotecnología y la química y biología moderna fueron desarrollados basándose en los principios elementales de la mecánica cuántica. Estos incluyen la idea de la cuantización de la energía, de existencia de estados discretos, la interferencia de probabilidades y hasta en algunos casos, de la dualidad partícula-onda. Sin embargo, por muchos años, fenómenos como la superposición de estados y, más particularmente, el entrelazamiento cuántico, vivieron en el mundo de la física fundamental, de la mano de esfuerzos científicos para comprenderlos o validarlos.

Hoy estamos viviendo una segunda revolución cuántica, enfocada en las aplicaciones de los aspectos más antiintuitivos de la mecánica cuántica. Fenómenos como la superposición de estados cuánticos y el entrelazamiento son la base de los nuevos paradigmas para la transmisión, almacenamiento y procesamiento de la información. Estos desarrollos son posibles gracias a experimentos como los de Aspect, Clauser y Zeilinger, que demostraron no solo que estos aspectos forman parte de la rareza de la naturaleza, sino que tienen varias aplicaciones. Por todo esto, resulta imposible no partir de las motivaciones fundamentales para entender la importancia del premio entregado este año.

Las propiedades antiintuitivas del entrelazamiento fueron señaladas por primera vez por Albert Einstein, Boris Podolsky y Nathan Rosen (EPR) en un artículo que escribieron en 1935. El argumento que elaboran es conocido como la ‘paradoja de EPR’ y tuvo como fin criticar la mecánica cuántica y descubrir inconsistencias en su estructura para demostrar entonces que el marco teórico no describe de manera completa la naturaleza.

Según los autores, si la teoría estuviera bien, nos dirigiría a una de las siguientes conclusiones: o bien existía una cierta interacción entre las partículas, incluso si estaban separadas espacialmente (Einstein se refería a este hecho como ‘acción fantasmagórica a distancia’), que hoy llamamos no-localidad; o teníamos que abandonar la idea de que la información acerca de los resultados de todas las mediciones posibles ya estaba presente en ambas partículas, abandonar lo que hoy llamamos realismo. Los autores propusieron una teoría alternativa, según la cual la información se codifica en algunas ‘variables ocultas’.

Esta discusión permaneció casi treinta años en el ámbito de la filosofía. En 1964, John Bell propuso una forma matemática para poder verificar la paradoja EPR (y las teorías de variables ocultas) en forma de una desigualdad que involucra medidas de correlación hechas por dos observadores. Si Einstein tenía razón, las desigualdades de Bell serían ciertas y la teoría cuántica, incompleta. Si, en cambio, la teoría cuántica era completa, estas desigualdades serían violadas. Una violación de las desigualdades de Bell implica, entonces, que la mecánica cuántica describe adecuadamente la naturaleza y por lo tanto esta es incompatible con alguna (o ambas) de las hipótesis de realismo y localidad.

Desde la aparición de la desigualdad de Bell se han llevado a cabo una gran cantidad de experimentos (cada vez más sofisticados) para poner a prueba estas hipótesis. De hecho, el primer experimento que demostrara algunas características del entrelazamiento ya había sido hecho por Chien-Shiunh Wu, en 1950 (catorce años antes) con fotones gamma que eran generados por aniquilación de positrones. Sin embargo, la imposibilidad de contar con buenos polarizadores para este tipo de fotones energéticos hacía que las medidas no fueran del todo concluyentes.

Luego el primer experimento en el que se midió la violación de las desigualdades de Bell fue realizado por Freedman y Clauser en 1972. En este experimento, pares de fotones entrelazados eran creados a partir de un átomo excitado de calcio, y enviados en direcciones opuestas hacia un conjunto de filtros polarizadores. Cambiando la orientación de los polarizadores observaron que la tasa de coincidencias medida superaba el límite que impone una teoría realista-local. Si bien el experimento de Freedman y Clauser representó un paso importante en la demostración experimental de la validez de la mecánica cuántica, los escépticos argumentaron que el experimento no descartaba completamente la existencia de variables ocultas, ya que la orientación de cada polarizador se fijaba antes de la emisión de los fotones. Esto representaba una limitación ya que la información sobre las mediciones a realizar estaba disponible en el momento en que se generaron los fotones, lo que se conoce como loophole de localidad.

A lo largo de los años siguientes se realizaron varios experimentos, entre ellos se destaca particularmente el realizado por Aspect en 1982. Si bien el arreglo experimental era similar al de Clauser, el experimento de Aspect era más sofisticado desde el punto de vista tecnológico, lo que le permitió cerrar el loophole de localidad. Para esto, la elección de la orientación de los polarizadores se realizaba de manera seudoaleatoria una vez que los pares de fotones hubieran sido generados. Esta selección se realizaba en pocos nanosegundos, garantizando que la información sobre la orientación de un polarizador no pueda alcanzar e influir al del otro lado, es decir, garantizando la independencia entre los dos observadores.

De la mano de un resultado tan importante, también los escépticos pusieron la lupa y aparecieron otras objeciones (loopholes). Finalmente, y después de arduos años de intentos, entre 2015 y 2016 se realizaron tres experimentos, en distintos laboratorios del mundo y utilizando distintas técnicas, que mostraron que las desigualdades de Bell eran violadas en situaciones en las que no había loopholes significativos. Es decir, todos los experimentos favorecieron el rechazo de que la naturaleza puede ser descripta por una teoría realista y local o, dicho en el lenguaje de Bell, por una teoría de variables ocultas locales.

También en esos años, de la mano de la segunda revolución cuántica, hubo un fuerte desarrollo teórico vinculado a aplicaciones prácticas utilizando estados cuánticos para codificar información, como los protocolos de distribución cuántica de claves y aplicaciones más extravagantes como la teleportación cuántica. Lejos de ser un relato de ciencia ficción, la teleportación cuántica es un protocolo por el cual es posible transferir el estado de una partícula a otra mediante la combinación de entrelazamiento y comunicación clásica. En 1997 Anton Zeilinger y su grupo realizaron la primera demostración experimental de este protocolo de teleportación cuántica, en paralelo con el grupo de Sandu Popescu y Francesco De Martini. Ambos experimentos utilizaban fotones entrelazados para la realización del protocolo.

Zeilinger continuó a la vanguardia de las aplicaciones, realizando posteriormente experimentos de entanglement swapping (teleportación de entrelazamiento), entrelazamiento multipartito (entre más de dos partículas), distribución del entrelazamiento a grandes distancias tanto en aire como en fibra óptica y criptografía cuántica. Todo esto contribuyó además al desarrollo tecnológico de fuentes de fotones entrelazados, generadores de números aleatorios, sistemas de puntería para comunicaciones cuánticas en aire, detectores de alta eficiencia, entre otros.

En la actualidad experimentos de teleportación y criptografía cuántica se realizan a distancias de cientos de kilómetros en fibra óptica y miles de kilómetros entre la tierra y estaciones satelitales. El grupo de Jian-Wei Pan en China es pionero y líder indiscutido en este tipo de comunicaciones cuánticas. No sorprende saber que Jian-Wei Pan es discípulo de Anton Zeilinger (quien fue su director de doctorado) y es además el primer autor en el paper de teleportación realizado por el grupo de Zeilinger que mencionamos anteriormente. En la Argentina también contamos con equipos que trabajan en ciencia y tecnología cuántica asociada al entrelazamiento. Por ejemplo, en el Laboratorio de Óptica Cuántica de CITEDEF se midieron por primera vez las desigualdades de Bell en 2009 y hoy se continúa trabajando con estados entrelazados de la luz desarrollando aplicaciones a comunicaciones seguras y a metrología cuántica.

Las aplicaciones tecnológicas de la mecánica cuántica han abierto un amplio campo de investigación y desarrollo donde el entrelazamiento cuántico juega un rol fundamental. La computación cuántica, la comunicación cuántica, las simulaciones cuánticas y la metrología cuántica y sensado son algunas de las áreas principales de investigación. Los experimentos ideados por John Clauser y Alain Aspect dieron inicio a la segunda revolución cuántica, evidenciando de manera empírica ciertas predicciones de la mecánica cuántica y sentando las bases experimentales para la generación y manipulación del entrelazamiento. Los trabajos desarrollados por Anton Zeilinger, pionero tanto en aplicaciones como en fundamentos, han demostrado el sorprendente potencial del entrelazamiento como recurso para las nuevas tecnologías cuánticas.

Los experimentos desarrollados por los tres galardonados no solo confirmaron la teoría cuántica, sino que abrieron el camino para un nuevo campo de la ciencia y la tecnología, tendiendo un puente entre los fundamentos y las aplicaciones de la mecánica cuántica.

Laura Knoll

Doctora en ciencias físicas, FCEN-UBA.

Investigadora asistente, Laboratorio de Óptica Cuántica, CITEDEF-Conicet.

Docente ayudante de primera, Departamento de Física, FCEN-UBA.

[email protected]

Christian Schmiegelow

Doctor en ciencias físicas, FCEN-UBA.

Profesor adjunto interino, Departamento de Física, FCEN-UBA.

Investigador adjunto, CIC-Conicet.

Director del Laboratorio de Iones y Átomos Fríos, Departamento de Física e Instituto de Física de Buenos Aires, UBA.

[email protected]

QUÍMICA

La química al alcance de un clic

La facilidad de la vida actual (donde hacemos muchas cosas mediante un clic) también alcanzó a la química. Y esto es lo que se ha premiado con el Nobel de la disciplina en 2022, donde Barry Sharpless (Nobel de química 2001, profesor en Scripps Research Institute, Estados Unidos) y Morten Meldal (profesor en la Universidad de Copenhague, Dinamarca) fueron reconocidos por sus aportes en llevar esta área de la ciencia a lo funcional, mediante una serie de reacciones que simplifican y aceleran los procesos de síntesis orgánica (química clic). En tanto, la tercera premiada, Carolyn Bertozzi (profesora de Stanford e investigadora del Howard Hughes Medical Institute, Estados Unidos) tomó el desafío de hacer estas reacciones ‘clic’ compatibles con la vida, un área que hoy se conoce como química bioortogonal. Este salto cuantitativo lleva a facilitar la síntesis de nuevas drogas y materiales, y a comprender mejor procesos fisiológicos y patológicos mediante herramientas químicas.

La Real Academia de Ciencias de Suecia, por segundo año consecutivo, ha premiado avances en la química orgánica. También conocida como la química del carbono, esta parte de la disciplina apunta a la construcción de moléculas de diferente tipo basadas en este elemento, desde nuevos materiales hasta moléculas de utilidad terapéutica. Y como el carbono es la base de la vida, desde los inicios la propia naturaleza fue una gran inspiradora. Imitar las complejas estructuras que encontramos en microrganismos, plantas y animales (muchas de ellas utilizadas, por ejemplo, como terapéuticos) en el laboratorio ha conllevado un gran desafío.

Lo más irónico (y a veces frustrante) de la síntesis de moléculas orgánicas es que lograr las uniones que las forman de manera simple y eficiente es dificultoso. La vida ha evolucionado para crear moléculas complejas de manera maravillosamente eficaz, pero en el laboratorio la cosa se complica… no tenemos todas las herramientas de la naturaleza. Como ejemplo, el carbono necesita ayuda para reaccionar (lo que conocemos como activación); al activarse, puede reaccionar ‘de más’, dando como resultado otras reacciones no esperadas y, en consecuencia, moléculas adicionales a la buscada (subproductos), los que deben ser separados, lo que suma tiempo y costo. Y ya que una síntesis rara vez involucra una sola reacción, todo lo discutido vale para cada paso secuencial, desde los reactivos originales hasta el producto final.

La química orgánica es hermosa y muy complicada. ¡Pero a no desanimarse! Este año, la Academia Sueca premia la llegada de nuevas ideas que hacen del mundo de la síntesis orgánica un área más simple y funcional.

Barry Sharpless y Morten Meldal: ¡la química clic!

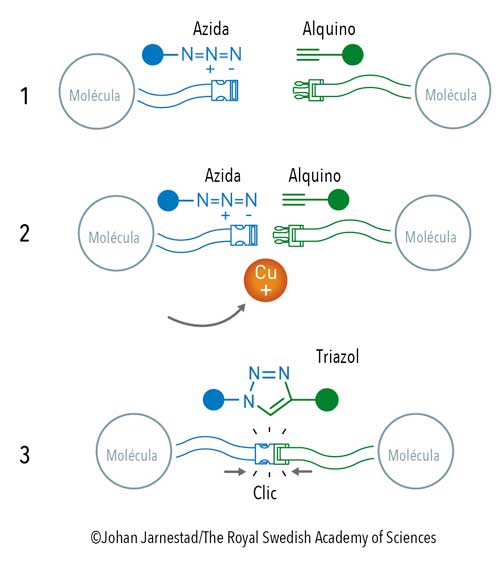

Para Barry Sharpless, este es su segundo premio Nobel. En 2001 recibió el primero por la catálisis asimétrica (junto con William S Knowles y Ryoji Noyori), pero la historia nos marca en este científico algo más allá de sus desarrollos específicos: su visión. Sharpless publicó, ese mismo 2001, un artículo de revisión en Angewandte Chemie donde planteaba la necesidad de una aproximación más simple y minimalista a la química. Proponía armar un kit de muy buenas herramientas que los químicos tuvieran disponibles para producir moléculas más fácilmente. En este artículo aventuraba integrar (optimización mediante) un abanico de reacciones robustas, irreversibles, con pocos subproductos o que, si los tenían, fueran fáciles de separar, que permitieran la producción de una diversidad de compuestos en solventes amigables (como el agua) y finalmente, posibles en presencia de oxígeno. A esto lo llamó química clic. En su lista de potenciales reacciones, estaba la cicloadición 1,3-dipolar entre azidas y alquinos que, si bien requería ciertos ajustes, era muy prometedora.

En ese mismo año, pero en Dinamarca, Morten Meldal trabajaba construyendo lo que hoy llamamos librerías de compuestos, conjuntos de cientos o miles de sustancias a las que luego se les evaluaba actividad farmacológica. Durante su trabajo, y como suele suceder en la química, se encontró con un resultado que no esperaba: al utilizar cobre como catalizador en una reacción entre alquino y azida, la reacción no solo era rápida y eficiente, sino específica: había nacido la cicloadición azida-alquino catalizada por cobre. Independiente y casi simultáneamente, Barry Sharpless seguía trabajando en su idea del ‘catálogo de reacciones simples y eficientes’, y demostró que esta misma reacción (que él había propuesto como clic, y con la ayuda de cobre como propuso Meldal, pero con algunos ajustes adicionales) se podía hacer en agua de manera eficiente.

Desde hace veinte años, el trabajo pionero de estos dos especialistas se extendió como fuego. Hoy hablamos de química clic como un área de desarrollo y amplia aplicación, un diverso conjunto de reacciones de química orgánica sencillas, eficaces y selectivas, que pueden ser usadas para la síntesis rápida y poco costosa de nuevos compuestos y librerías combinatoriales (es decir, compuestos que se obtienen por combinación de pequeñas subunidades).

La química clic hoy se aplica tanto en el ámbito académico como en el industrial, no solo en la producción de moléculas con potencial actividad biológica sino también en el área de materiales, donde a través de estas reacciones se puede modificar sus propiedades (por ejemplo, hacerlos capturar la luz del sol o conducir electricidad).

Pero… no es lo mismo hacer una reacción en agua (que es el medio de la vida y las reacciones biológicas) que hacerlo en una célula. Las reacciones que se llevan adelante en una célula son más que compatibles con agua, ya que la química celular es muy compleja y está específicamente regulada para mantener la vida. Y no solo eso: en la célula tenemos una enorme cantidad de moléculas que pueden reaccionar. No controlamos, como en el tubo de ensayo, qué reactivos hay y en qué proporción. A veces esas reacciones laterales pueden alterar la funcionalidad celular, o matarla. Y ni pensar en los organismos multicelulares, donde podemos encontrar complejos sistemas jerárquicos formados por numerosas partes que deben funcionar de manera coordinada (por ejemplo, nuestro propio organismo).

La química biológica es hermosa y, aún más, complicada. Y entonces llegó la química bioortogonal.

Carolyn Bertozzi y la química bioortogonal

Alla por los años 90, cuando la biología molecular revolucionó la bioquímica dándonos herramientas para entender genes y proteínas, seguíamos sin muchas herramientas para comprender la función de los carbohidratos (componentes esenciales de la célula, no solo desde el punto de vista energético y nutricional, sino funcional). Ya hace muchos años se sabe, por ejemplo, que diversos procesos biológicos se llevan adelante mediados por carbohidratos presentes en la superficie celular: la invasión de un virus o la colonización de una bacteria puede estar mediada por el reconocimiento de estos azúcares. Pero el problema es que los glicanos (carbohidratos que se presentan en superficie a veces unidos a proteínas, a veces a lípidos) eran muy difíciles de estudiar. A diferencia de los genes o las proteínas, los glicanos se sintetizan sin un molde a seguir, y suelen presentar un rango muy variado de estructuras. Por ello, el área de la glicómica funcional (que se dedica a estudiar la estructura de estos glicanos y su función) fue desarrollándose más lentamente que la genómica o la proteómica.

Bertozzi en ese entonces estaba trabajando justamente en comprender la función de los glicanos de superficie celular, y se planteó lo siguiente: ¿por qué no buscamos alguna reacción que nos permita ‘marcar’ estos carbohidratos para ‘verlos’ en la célula? La idea era darle a la célula un carbohidrato con una etiqueta visible, y reconocer su posición.

Entre 1997 y 2000 (cuando Sharpless aún no había ganado el primer Nobel y Meldal estaba sintetizando grandes cantidades de compuestos a la manera tradicional, antes de la química clic) Bertozzi probó diferentes tipos de marcas, hasta que en el año 2000 la encontró. Su trabajo, publicado en Science, mostraba que si a la célula se le daba carbohidratos ‘marcados’ con azida (azidoazúcares), los incorporaba en la superficie celular, y usando otra molécula fluorescente que reaccionaba específicamente con azida, se los podía ‘ver’ en la superficie. Unos años después, demostró que esta reacción también se podía realizar directamente en animales.

Había nacido la química bioortogonal, reacciones que pueden ser realizadas en condiciones fisiológicas sin interferir, o ser afectadas, por los procesos biológicos.

Cuando los desarrollos de Morten Meldal y Barry Sharpless se hicieron públicos, Bertozzi se da cuenta de que combinando azida con alquino y en presencia del catalizador adecuado (el cobre), la reacción era más rápida y eficiente. Pero (y siempre hay un pero) el cobre es tóxico para las células, por lo que había que buscar la manera de mantener la eficiencia sin el catalizador… Volviendo a las bases (vale recordar que los científicos siempre trabajamos sobre hombros de gigantes), se encontró con una publicación de la década de 1960, donde dos científicos alemanes (uno de ellos Georg Wittig, premio Nobel de química 1979 por otra reacción, que hoy lleva su nombre) habían descripto algo muy interesante: la reacción azida-alquino era extremadamente eficiente si el alquino estaba inmerso en una estructura cíclica. El alquino está tan tensionado que se torna activo per se, sin necesidad del cobre para reaccionar.

¿Y si en vez de usar cobre, intentamos tensionando el alquino?

Así, Bertozzi desarrolló la cicloadición alquino-azida promovida por tensión y libre de cobre, una reacción que podía rastrear azúcares en la superficie celular y en organismos vivos de manera eficaz. Podríamos decir que esta reacción es exponencialmente clic, ¡clic al cuadrado! Fácil, eficiente, en medio acuoso y compatible con la vida.

Esto fue solo el comienzo de un área que se expandió con el trabajo de otros investigadores, sumando reacciones compatibles con la vida y que pueden facilitar la comprensión de procesos biológicos complejos, el rastreo de moléculas en el metabolismo, el diagnóstico de enfermedades o el delivery de drogas de manera más específica.

Como ejemplo, la química bioortogonal ha dado un nuevo impulso a la generación de conjugados anticuerpo-fármaco, que pueden conseguir terapias más específicas y eficaces. En particular, Bertozzi se ha dedicado a los azúcares de superficie celular y su función en el desarrollo de tumores. Las células tumorales, para no ser eliminadas por el sistema inmune, ‘muestran’ carbohidratos específicos que metafóricamente provocan una hipnosis que duerme a las células inmunes, y el tumor así sobrevive y se expande. Su trabajo ha resultado en un biofarmacéutico donde un anticuerpo dirigido al tumor está unido (conjugado) a una enzima que corta ese carbohidrato ‘hipnótico’ y al eliminarlo el sistema inmune se despierta y ataca al tumor. Este bioterapéutico está siendo hoy probado en ensayos clínicos para pacientes con tumores avanzados.

En palabras de la propia Carolyn Bertozzi en una entrevista realizada al comunicársele el otorgamiento del Nobel: ‘Cuando el mundo se encuentra en problemas, la química puede venir al rescate’.

El premio Nobel de este año en química va con la idea de funcionalidad y practicidad, un reconocimiento a la creatividad y el valor para enfrentar los desafíos que la química de la vida representa. Y tiene mucho potencial. Porque como dijo Venkatraman Ramakrishnan (premio Nobel en química 2009 junto con Thomas A Steitz y Ada E Yonath), ‘en lo profundo, cualquier pregunta biológica es un problema químico’.

Karina V Mariño

Doctora en ciencias químicas, UBA.

Investigadora independiente del

Conicet en el IBYME.

Profesora adjunta, Universidad

Argentina de la Empresa (UADE).

[email protected]

ECONOMÍA

Fragilidad financiera y fluctuaciones económicas

Este año, el premio en Economía instituido por el Banco de Suecia en memoria de Alfred Nobel fue otorgado a tres economistas estadounidenses de perfiles distintos, con un largo recorrido en la investigación sobre temáticas cuyos rasgos comunes han sido los aspectos macroeconómicos del comportamiento de los sistemas financieros, con énfasis sobre el estudio de las perturbaciones marcadas por crisis. Ben Shalom Bernanke realizó una actividad académica que incluyó trabajos teóricos y estudios de orientación aplicada, y tuvo una participación de muy alto perfil en la gestión de políticas en tiempos turbulentos, como presidente de la Reserva Federal de los Estados Unidos durante la profunda crisis financiera y económica de los años 2000. Por su parte, los otros dos premiados se concentraron en la modelización teórica, con una contribución central; nos referimos a Douglas W Diamond y Philip H Dybvig, quienes en 1983 publicaron su influyente texto ‘Bank runs, deposit insurance, and liquidity’ (Journal of Political Economy, 6 de enero de 1983: 401-129; DD en adelante), el cual muy probablemente pesó de manera decisiva en la decisión del jurado.

Los influyentes trabajos iniciales de Bernanke estuvieron motivados por la búsqueda de explicaciones para la gran intensidad de la caída de la actividad durante la Gran Depresión. Para entonces, en consonancia con el argumento de Milton Friedman y Anna Schwartz en su Historia monetaria de los Estados Unidos de 1963, se enfatizaba generalmente la relevancia de las perturbaciones en el sistema bancario, vía su efecto sobre la oferta de dinero. Sobre la base de una lectura informada de la evidencia histórica, en 1983 Bernanke destacó en su análisis la centralidad del sistema financiero como inductor de efectos recesivos y, aunque tuvo cuidado de insistir sobre su complementariedad con las hipótesis de Friedman, giró la atención hacia los desarreglos de la intermediación y de la oferta de crédito, es decir, hacia el activo de los bancos. Este desplazamiento de foco contribuyó a un movimiento afín en la literatura. Un signo se encuentra en el propio DD: ‘Una importante propiedad de nuestro modelo de bancos y corridas bancarias es que las corridas son costosas… porque interrumpen la producción […] y destruyen mecanismos para compartir riesgos entre depositantes […] Esto es consistente con la observación de Friedman y Schwartz respecto del alto costo de las corridas, aunque ellos atribuyen el daño al efecto vía la oferta monetaria […] Un estudio de Bernanke apoya nuestra tesis, porque muestra que las corridas bancarias son un mejor predictor de las contracciones económicas que la oferta monetaria’.

Bernanke se ocupó también particularmente, en diversos trabajos en colaboración con Mark Gertler, del análisis y la modelización de los efectos de las condiciones financieras en la actividad real, principalmente sobre la base de un esquema –en 1989– donde la asimetría de información entre acreedores y deudores acerca del retorno realizado de los proyectos de inversión lleva a que el costo del financiamiento con recursos prestados sea más oneroso que el constituido con fondos propios. Así, un aumento exógeno en el patrimonio de los emisores de deuda alivia las restricciones de crédito y permite aumentos ulteriores de la actividad (y viceversa, ante shocks negativos que restringen la oferta de préstamos).

La preocupación por el impacto contractivo de las corridas financieras y de las retracciones del financiamiento se encuentra en importantes piezas de análisis tradicionales (véase, por ejemplo, el texto de Walter Bagehot de 1873) y aportes más recientes como los de Charles P Kindleberger en 1978 y Hyman P Minsky en 1975. En DD, Diamond y Dybvig buscaron elaborar un esquema formal que racionalizara la existencia de los bancos y señalara determinantes de su fragilidad. Así, elaboraron un argumento basado en uno de los aspectos de la actividad bancaria, como es la ‘transformación de plazos’, es decir la emisión de promesas de pago a corto plazo siendo que el lapso de maduración de sus activos es mayor, lo que permite a los consumidores con urgencias de fondos aprovechar la productividad comparativamente alta de los emprendimientos de mayor duración, a riesgo de abrir la posibilidad de que emerjan ‘problemas de liquidez’.

El impacto que tuvo el modelo amerita describirlo con algún detenimiento. La economía representada contiene un continuo de agentes y un horizonte temporal de tres períodos (t = 0, 1, 2). Cada uno de los individuos recibe una asignación de una unidad de bienes (homogéneos) y tiene la oportunidad de encarar un proyecto productivo (que aprovechará en la medida en que no deriva utilidad de consumir en ese período). El proyecto promete, con certeza, recuperar, y solo recuperar, en t = 1 la unidad de bienes invertida si el agente decide terminar ahí la ejecución del proyecto. En ese momento está disponible una ‘tecnología de almacenaje’ que permite, con un retorno unitario, trasladar bienes a t = 2. Si, en cambio, el agente decide mantener el proyecto ‘en operación’ en t = 1 recibe un retorno de magnitud (certera) R > 1 en t = 2. Esta propiedad encapsula una hipótesis central del modelo, como es la superioridad de rendimiento de las inversiones de mayor duración respecto de las de corto plazo. En t = 1 se produce, de manera aleatoria, una diferenciación crucial entre los agentes del modelo, que separa, al azar, a quienes tienen ‘urgencia de consumir’ (deriva utilidad solo del consumo en ese momento) de aquellos que generan utilidad del consumo ‘tardío’, en t = 2.

En autarquía, los agentes ‘urgidos’ deben liquidar sus proyectos prematuramente, mientras que los tardíos esperan y pueden aprovechar plenamente la alta productividad del proyecto de largo plazo. De esta manera, resulta conveniente un mecanismo de seguro que permita a los agentes que se revelan ilíquidos en la lotería de la diferenciación consumir algo más que en autarquía. Si el tipo de los agentes (urgido o tardío) fuera observable, esa asignación sería alcanzable vía contratos bilaterales entre los individuos, pero este mecanismo no funcionaría cuando el tipo de los agentes fuera información privada.

En DD, los ‘bancos’ se representan como instituciones dirigidas a superar esa ineficiencia y actúan para ofrecer a los agentes urgidos una porción de las ganancias de productividad de las inversiones a mayor plazo. El banco estilizado del modelo DD es un ente que actúa como si estuviera en un entorno competitivo (cero beneficios), tiene acceso a la misma tecnología que los productores/consumidores, recibe depósitos de bienes en t = 0 por parte de esos agentes y emite certificados de deuda que prometen pagos fijados en términos de bienes en t = 1. El banco es liquidado en t = 2; los recursos remanentes son repartidos proporcionalmente a sus acreencias entre los depositantes que no realizaron el retiro de sus activos en el período anterior.

Como supuesto importante, en t = 1 el banco está sujeto a la ‘condición de servicio secuencial’, que le exige atender a los clientes que desean retirar sus depósitos en orden de llegada y, dado eso, pagar el pleno valor de la deuda fijado en el compromiso original mientras alcancen los activos remanentes, lo cual implica que, de agotarse los recursos, el banco va a la quiebra con un conjunto de depositantes ‘en la cola’, que quedan sin recibir pago alguno.

La intermediación por parte del banco puede estar en condiciones de implementar el óptimo social. Dados los depósitos en t = 0, por cada unidad de bienes recibidos, el banco promete una devolución en t = 1 por valor igual al consumo que tendría en aquel óptimo un consumidor urgido. Entonces, si solamente los consumidores tempraneros cancelan sus depósitos en t = 1, los recursos que quedan disponibles en el banco son tales que permiten exactamente que los agentes tardíos consuman según los montos del óptimo social.

Pero no es seguro que el resultado sea ese. El modelo abre la posibilidad de una fragilidad intrínseca en el diseño del banco. Si, una vez constituidos los depósitos en t = 0, los tardíos de algún modo coordinan sus expectativas con la previsión de que los congéneres correrán a retirar sus depósitos, cada uno tiene incentivo de unirse a la estampida, porque el banco no tiene recursos suficientes para cumplir con su promesa. A su vez, la percepción de los agentes respecto de la probabilidad de un mal equilibrio afectaría las chances mismas de surgimiento del banco.

La eventualidad de una corrida no está anclada aquí en ninguna condición fundamental. Pero, entonces, ¿cómo se forman las previsiones de los agentes cuando se trata de adivinar adivinanzas de adivinanzas y sucesivas profundidades? En todo caso, surge la pregunta sobre las intervenciones de política que permitirían atajar corridas contra bancos ‘solventes pero ilíquidos’. Si la cantidad de consumidores urgidos es conocida, limitar los retiros en t = 1 a ese número de depositantes resolvería el problema, porque la magnitud de los fondos devueltos en ese período sería siempre no mayor que los retiros tempranos en el equilibrio sin corrida: en consecuencia, ningún agente tardío tiene incentivos a ponerse en la cola de retiros, y la corrida se diluiría. En DD encuentran que esa medida de ‘suspensión de convertibilidad’ de los depósitos no funcionaría si el número de consumidores impacientes fuera aleatorio, y que un esquema de garantía de depósitos puede producir contratos mejores, sujeto a las características del arreglo fiscal subyacente a su financiamiento.

Diamond siguió trabajando, con apreciable impacto, en el filón abierto por DD. Unos años después de DD, en 1984, publicó un artículo analizando el rol de los bancos en resolver problemas de incentivos entre acreedores y deudores sobre la base de su superioridad para procesar información acerca de las condiciones de los demandantes de crédito. Posteriormente, desarrolló modelos centrados en los altibajos de la liquidez de los agentes financieros, y sus efectos reales (por ejemplo, Diamond D y Rajan R, ‘Liquidity risk, liquidity creation and financial fragility: A theory of banking’, Journal of Political Economy, 109 (2): 287-327; ‘The credit crisis: Conjectures about causes and remedies’, The American Economic Review, 99 (2): 606-610), y se interesó en los procesos asociados con la crisis financiera y macroeconómica de los 2000 en el último de los artículos citados.

Con su formulación canónica y relativamente simple, DD tuvo una amplia aceptación y fue adoptado de manera difundida como referencia básica cuando se trata de analizar implicancias de las condiciones financieras. El artículo es un elemento usual de las listas de lectura en cursos referidos a esos temas. Como indicador de la sostenida pertinencia asignada al modelo, el interés profesional por DD manifestado en citaciones ha sido considerable a lo largo del tiempo, y mostrado una asociación con la ocurrencia de desarreglos financieros como los de finales de los 2000.

Daniel Aromi

Ph.D. en economía, University of Maryland at College Park, Estados Unidos.

Profesor investigador, Facultad de Ciencias Económicas, UCA.

Profesor asociado regular, UBA.

[email protected]

Daniel Heymann

Ph.D. en economía, Universidad de California, Los Ángeles, Estados Unidos.

Profesor emérito, UBA.

[email protected]

Biólogo y doctor en ciencias químicas, UBA.

Profesor emérito, FCEN, UBA.

Investigador superior contratado, Conicet.