¿Cuáles son las contribuciones al conocimiento realizadas por los ganadores de premios que, a lo largo de más de un siglo, se convirtieron en uno de los mejores mecanismos del mundo para identificar avances cruciales de las ciencias?

FÍSICA

Las oscilaciones y la masa de los neutrinos

El premio Nobel de física de este año fue concedido a Takaaki Kajita, de la Universidad de Tokio, y a Arthur McDonald, de Queen’s University en Canadá, por el descubrimiento de las oscilaciones de los neutrinos, una indicación de que estos tienen masa. Los neutrinos, que se denotan con la letra griega nu (ν), son partículas subatómicas que interactúan solo débilmente con la materia (ya que no tienen carga eléctrica ni sienten el efecto de la fuerza fuerte, que mantiene ligados a los protones y neutrones en los núcleos atómicos). Por ello son sumamente difíciles de detectar. Se producen, por ejemplo, en los decaimientos beta de la radiactividad natural, que son procesos en los que un núcleo atómico se convierte en otro más liviano emitiendo un electrón (la partícula beta) y un neutrino. De hecho, la existencia de los neutrinos fue postulada por Wolfgang Pauli (1900-1958, premio Nobel de física 1945) en 1930 justamente para explicar por qué el electrón se lleva solo una fracción de la energía disponible en dicho proceso; el resto se lo debe llevar una partícula neutra y liviana que no se observa directamente.

Con los años se descubrió que existían otras dos partículas similares al electrón, con idénticas interacciones pero bastante más pesadas: el muón (μ), que es unas 200 veces más pesado que el electrón, y el tau (τ), unas 3500 veces más pesado que el electrón. Cada una de estas partículas tiene asociado un neutrino distinto, de modo que se dice que los neutrinos vienen en tres ‘sabores’: el del electrón (νe), el del muón (νμ) y el del tau (ντ). El ne, por ejemplo, se produce junto con el electrón en los decaimientos radiactivos y, cuando interactúa con la materia, se produce un electrón. En cambio, el νμ aparece junto con los muones generados en la desintegración de partículas más pesadas. Cuando se estudió la interacción de los νμ con la materia colocando detectores cerca del lugar en el que habían sido generados, se vio que producían muones pero no electrones, indicación de que son distintos de los νe. Algo similar sucede con los ντ, resultado, por ejemplo, de ciertos decaimientos de partículas muy pesadas en los que se producen partículas tau: al observar en un detector las interacciones de los ντ con la materia, se advierte que solo se producen taus pero no electrones ni muones.

Durante mucho tiempo se pensó que los neutrinos podían no tener masa y los varios intentos de determinarla solo resultaron en límites superiores. Hoy sabemos que sus masas son inferiores a una millonésima parte del valor de la masa del electrón, que es la partícula cargada más liviana que se conoce. Por qué los neutrinos son tanto más livianos que las demás partículas es una pregunta que aún no sabemos responder a ciencia cierta.

Lo notable de los experimentos liderados por los dos físicos premiados es que lograron establecer que las masas de los neutrinos no son nulas. Estos experimentos fueron el Super-Kamiokande ubicado en Japón, liderado por Kajita, y el Subdury Neutrino Observatory ubicado en Canadá, liderado por McDonald. El experimento Super-Kamiokande consiste en un detector de 50.000 toneladas de agua más dispositivos que registran la luz producida cuando un neutrino interactúa con el líquido.

El experimento canadiense se compone de un detector más pequeño que contiene 1000 toneladas de agua pesada. El agua pesada (D2O) se distingue del agua común (H2O) porque en lugar de hidrógeno tiene deuterio, en cuyo núcleo, además de un protón, como el hidrógeno, hay un neutrón, lo que lo hace más pesado. Para poder detectar a los neutrinos sin interferencias debidas a rayos cósmicos u otro tipo de radiación, estos experimentos se realizan entre 1 y 2km bajo tierra, en el sitio de alguna mina profunda o debajo de una montaña.

Ambos experimentos mostraron que los neutrinos podían cambiar de identidad al propagarse en distancias grandes, y que lo hacían de manera oscilatoria: de ahí que se hable de oscilación de los neutrinos. El experimento Super-Kamiokande estudió cómo oscilaban los neutrinos del muón, producidos en la atmósfera terrestre por las colisiones de los rayos cósmicos, que son partículas que nos bombardean constantemente desde el espacio exterior. Se constató que al observar los neutrinos del muón provenientes desde arriba, que habían viajado típicamente una distancia de unos 20km desde su lugar de producción en la alta atmósfera, se detectaba la cantidad de νμ que se esperaba; en cambio, para los que provenían desde abajo, que habían sido producidos en las antípodas y habían viajado más de 10.000km atravesando la Tierra, casi la mitad de esos νμ se habían convertido en neutrinos del tau. En otras palabras, estos neutrinos atmosféricos de muón, con energías elevadas, cambian su sabor en distancias de algunos miles de kilómetros.

El experimento canadiense estudió en cambio los neutrinos producidos en las reacciones nucleares que son la fuente de la energía del Sol, de las que resultan cuantiosas cantidades de neutrinos de electrón de bajas energías. Varios experimentos anteriores habían observado un flujo de νe inferior al que predecían los modelos del Sol, pero no se sabía si esto era debido a alguna incerteza en estos cálculos o a algún efecto físico que afectaba a los neutrinos en su viaje. La gran ventaja del detector con el que trabajó McDonald es que podía determinar separadamente cuántos de los neutrinos que llegaban del Sol eran νe, y cuál era el flujo total de los tres sabores de neutrinos. El experimento estableció que solo alrededor de un tercio de los neutrinos producidos en el Sol llegaron con el sabor con el que fueron producidos, es decir como νe, mientras que el resto se había transformado en neutrinos de otro sabor, ya sea νμ o ντ.

Estos cambios de identidad de los neutrinos se pueden entender como consecuencia de que tienen masa, y lo crucial es que debe haber tres neutrinos con masas distintas. De este modo, cada uno de los tres sabores será una mezcla de los tres neutrinos con masa definida. El hecho de que los neutrinos con distintas masas se propagan de modo un poco distinto hace que durante el viaje pueda cambiar el sabor del neutrino, que es la propiedad que se puede detectar observando cuál es la partícula que producen al interactuar con la materia, sea un electrón, un muón o un tau.

Estos experimentos permitieron obtener información sobre la diferencia entre las masas de los distintos neutrinos y también de cómo se mezclan las componentes con distintas masas en cada estado de sabor definido. Esta información es esencial para la física de partículas ya que nos indica cómo debe ser la teoría que describe a los neutrinos y que explica el origen de sus masas. Es de destacar que la mezcla de neutrinos con distintas masas presente en cada estado de sabor definido es realmente una superposición cuántica de estados, de modo que las oscilaciones de sabor detectadas representan un efecto cuántico que se puede observar a escalas macroscópicas.

También es relevante saber el valor de las masas de los neutrinos porque estas pueden tener un impacto importante en la evolución del universo y en la forma en que se producen las grandes estructuras en la distribución de la materia, como las galaxias o los cúmulos de galaxias. De hecho, se predice que una enorme cantidad de neutrinos, unos 300 por cada centímetro cúbico, están presentes en todo el espacio. Estos fueron producidos en los primeros instantes posteriores al Big Bang, cuando el universo era muy denso y caliente, se desacoplaron del resto de la materia a los pocos segundos y sobrevivieron hasta el día de hoy. Si los neutrinos tienen masa, su contribución total al contenido de materia del universo se torna no despreciable y puede tener efectos dinámicos debido a las fuerzas gravitatorias que producen, algo que termina afectando a la formación de las galaxias.

Los neutrinos también se producen copiosamente en las estrellas, especialmente en las muy masivas, y afectan su evolución. Cuando una estrella termina su vida en una explosión de supernova los neutrinos emitidos se llevan la mayor parte de la energía liberada.

El descubrimiento de las oscilaciones de los neutrinos por ambos experimentos, luego confirmado por otras varias observaciones, produjo un avance importante en el conocimiento de las propiedades de los componentes elementales de la materia. Quedan aún varias preguntas por responder relacionadas con los neutrinos, como la determinación del valor exacto de sus masas o si existen más sabores de neutrinos además de los tres que conocemos, que podrían ser más pesados o con interacciones aún más débiles. Este no es el primer premio Nobel otorgado que tiene relación con los neutrinos; quizá no sea el último.

QUÍMICA

La reparación del adn

Este año el premio Nobel de química fue dividido en partes iguales entre el sueco Tomas Lindahl del Francis Crick Institute en Gran Bretaña, el estadounidense Paul Modrich de la Universidad Duke y el Howard Hughes Medical Institute, y el turco-norteamericano Aziz Sancar de la University of North Carolina, tres científicos que identificaron, cada uno por su lado, algunos de los mecanismos clave de la reparación del ADN.

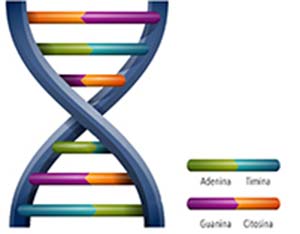

El ADN, que tiene la conocida forma de doble hélice, consiste en una sucesión de nucleótidos que pueden estar formados por cuatro tipos de bases distintas: adenina (A), citosina (C), guanina (G) y timina (T). La secuencia de nucleótidos contiene la información genética; por esto se podría esperar que el ADN no cambie durante la vida de un organismo. Sin embargo, suceden cambios cuyo resultado es tanto ADN dañado como ADN mutado (diferencia que explicaremos más adelante). Esto trae importantes consecuencias, desde la evolución de las especies hasta enfermedades genéticas o incluso cáncer.

Sabiendo que la información genética debe transmitirse con alta fidelidad de una célula madre a las dos células hijas que resultan de una división celular, la predicción inicial fue que el ADN era una molécula muy estable, parecida a un cristal. De hecho, ciertas evidencias hacían pensar que no podía ser de otra manera. Por ejemplo, la duplicación del ADN es semiconservativa. Eso significa que la doble hélice se abre como un cierre relámpago y cada mitad sirve como molde para el copiado de una nueva mitad, por lo que, al generarse dos células hijas, cada doble hélice está formada por una hélice completamente nueva y una hélice heredada. Si cada uno de nosotros se desarrolló a partir de una sola célula formada por el óvulo materno y el espermatozoide paterno, es muy movilizante pensar que, independientemente de nuestra edad, en algunas células de nuestro organismo todavía podemos tener fragmentos del ADN original que nos dieron nuestros padres. Si tiene que durar tanto tiempo, es lógico entonces suponer que nuestro ADN debe ser muy estable.

Pero no es así. En realidad, es extremadamente inestable. Mientras usted lee esta nota, el ADN de su cuerpo está sufriendo miles de alteraciones o daños que, si demora mucho su lectura, llegarán fácilmente al millón. Esto no se puede evitar ya que el origen de esos cambios químicos del ADN, por un lado, es el propio metabolismo que mantiene a nuestras células en funcionamiento y, por otro lado, una multitud de agentes externos que lo alteran, como la radiación ultravioleta. Así, una hora de exposición al sol incrementa el daño entre diez y veinte veces. Los mecanismos de reparación de ese daño –que reemplazan las secuencias alteradas o lesionadas por las originales sanas y nos permiten nacer y permanecer vivos– se conocen desde hace décadas gracias al trabajo de diversos investigadores, como Philip Hanawalt de la Universidad de Stanford.

¿Cuáles son esos mecanismos? Esa es la pregunta por cuyas respuestas los galardonados de este año recibieron el Nobel. Para comprender dichos mecanismos podemos imaginar que en el organismo están activos durante las veinticuatro horas del día y los siete días de la semana equipos de moléculas zurcidoras de ADN. Cada equipo tiene por lo menos tres grupos de trabajo. El primero, compuesto por moléculas de rastreo, revisa el ADN en busca de deformaciones o lesiones y, al encontrarlas, determina si el cambio químico puede ser reparado. En caso afirmativo, entra en funciones el segundo grupo, las tijeras, formado por moléculas llamadas nucleasas que cortan la hélice dañada con gran precisión a cada lado de la distorsión. Cumplido ese paso, entra a actuar el tercer equipo, las zurcidoras, que son polimerasas de ADN cuya tarea es rellenar la sección eliminada con el ADN sano que corresponde allí.

El procedimiento identificado por Lindahl se llama reparación por escisión de bases. Sancar descifró otro mecanismo: la reparación por escisión de nucleótidos. Modrich, por su lado, encontró cómo se produce la reparación de bases mal apareadas. El primer mecanismo elimina daños que afectan a una sola base; el segundo se encarga de lesiones que a veces fusionan dos bases adyacentes, mientras el tercero elimina bases no dañadas sino mal apareadas, y es capaz de determinar cuál de las dos es la equivocada.

¿Qué sucede con una lesión no reconocida por las moléculas rastreadoras, la cual, por ende, no es reparada? De por sí, es probable que no genere mayores alteraciones en el funcionamiento de la célula, pero obstruye el proceso de duplicación del ADN. Si las obstrucciones son muchas, la duplicación puede fallar y la célula muere, pero si no lo son, la célula se duplica y las lesiones provocan errores de copiado del ADN, es decir, mutaciones.

Como se aprecia, daño y mutación del ADN, si bien íntimamente relacionados, son hechos diferentes. La mutación no contiene ADN lesionado sino un cambio de la secuencia de bases que ocurre durante el proceso de copiado. Por ello los mecanismos de reparación no la advierten y, por lo tanto, resulta irreversible. En el siguiente evento de copiado, las mutaciones se consolidan como cambios heredables en la secuencia del ADN.

Como el ADN gobierna la producción de proteínas por el organismo, su alteración cambia la o las proteínas resultantes. Si esto modifica, por algún mecanismo, la influencia del entorno celular sobre la decisión de duplicación, el cambio puede causar que la célula se duplique sin referencia a esas necesidades y por su solo impulso, es decir, que se convierta en una célula cancerosa. Por esta razón, una falla de los mecanismos de reparación de ADN dañado puede abrir el camino al cáncer.

Existe una enfermedad hereditaria llamada xeroderma pigmentosa, por la que el mecanismo de reparación del ADN por escisión de nucleótidos no opera debido a la falta de ciertas proteínas. Quienes padecen esa enfermedad son extremadamente sensibles a los efectos de la radiación ultravioleta, pues su organismo no logra reparar los daños que provoca esta en el ADN. Como consecuencia, en ellos el cáncer de piel es frecuente y de evolución rápida, al punto que el 60% de esos pacientes muere antes de cumplir veinte años. Alteraciones en el mecanismo de reparación de bases mal apareadas, por otro lado, se han asociado con una mayor propensión hereditaria al cáncer de colon, mientras que defectos en el mecanismo de reparación de escisión de bases causa la muerte de ratones al momento del nacimiento.

Para comprender el aparentemente caprichoso camino de la naturaleza que llevó a la inestabilidad del material genético, conviene recordar que, si bien durante el lapso de nuestra vida sería conveniente que nuestro ADN no sufriera mutaciones, no habríamos existido sin ellas. Un ADN inmutable, sencillamente, no hubiese dado lugar a la evolución y la aparición de variaciones exitosas en las formas de vida. En otras palabras, sin este balance entre frecuentes lesiones del ADN y su reparación seríamos organismos más sencillos que las bacterias.

Si la riesgosa imperfección del material genético es la base de la evolución, ¿podremos algún día controlarla? Miles de las investigaciones actuales, que hacen esfuerzos para mejorar las herramientas de diagnóstico y tratamiento, han alcanzado avances modestos pero significativos. En el contexto de los premios Nobel, que apuntan a reconocer el valor del conocimiento, este no puso en relieve un descubrimiento de aplicación inmediata sino un avance en la dilucidación de mecanismos bioquímicos básicos esenciales para comprender con mayor profundidad la vida y la evolución.

MEDICINA

Lucha contra un enemigo invisible

El pasado 5 de octubre el Instituto Carolina de Suecia dio a conocer su decisión de otorgar el premio Nobel 2015 de fisiología o medicina de la siguiente manera: el 50% a la farmacéutica china Youyou Tu, de la Academia China de Medicina Tradicional, por sus descubrimientos sobre una nueva terapia contra la malaria; y el otro 50% por partes iguales al parasitólogo estadounidense de origen irlandés William Cecil Campbell, de Drew University, en Madison, Nueva Jersey, y al microbiólogo japonés Satoshi Omura, del Instituto Kitasato, de Tokyo, por sus descubrimientos sobre una nueva terapia contra las infecciones causadas por parásitos nematodos.

Disponemos de evidencia como para poder afirmar que los parásitos constituyen la biodiversidad oculta del planeta y que, como tales, son la forma de vida predominante en todos los ecosistemas. Prácticamente no hay especie viva que no albergue una o varias especies parásitas, incluyendo a millones de personas en el mundo actual, en las que causan enfermedades mortales o invalidantes.

Los parásitos que han venido combatiendo los galardonados tienen algo en un común: son transmitidos a las personas por la picadura de insectos hematófagos, como jejenes y mosquitos, y afectan en gran medida a las poblaciones más carenciadas del mundo. Más de 1200 millones de africanos están expuestos a ser picados por esos insectos, y anualmente muere de paludismo o malaria en el África subsahariana medio millón de enfermos, en un alto porcentaje menores de cinco años. En el mundo hay aproximadamente 280 millones de enfermos de malaria y se producen más de 600.000 muertes anuales.

Malaria o paludismo son los nombres vulgares de una parasitosis causada por varias especies de un protozoo del género Plasmodium, que infecta la sangre. Precisamente, el segundo Nobel de fisiología o medicina fue otorgado en 1902 al médico británico Ronald Ross (1857-1932) por su descubrimiento del ciclo de replicación del parásito Plasmodium falciparum (causante de la fiebre terciana maligna) en la hembra de mosquitos del género Anopheles, lo que abrió el camino para erradicar la enfermedad en extensos territorios del África occidental y otros continentes.

La biología de los plasmodios del paludismo es muy compleja. En el mosquito, el parásito, que es un organismo unicelular, se multiplica por un proceso de división llamado esporogonia y genera literalmente millones de organismos que se acumulan en las glándulas salivales del insecto y pasan al ser humano por las picaduras. Una parte obligada del ciclo de replicación del plasmodio ocurre en el hígado de las personas infectadas a los pocos días de sufrir la picadura. Luego el parásito infecta los glóbulos rojos, de los cuales se alimenta, degrada la hemoglobina y produce un pigmento oscuro y tóxico responsable de los recurrentes picos de fiebre del enfermo.

El sistema inmune reconoce eficazmente la presencia del parásito, por ejemplo en el cerebro o el riñón, y lo ataca de manera descontrolada, lo que desencadena reacciones de hipersensibilidad que terminan destruyendo el propio tejido. Como resultado se generan complicaciones en órganos como los nombrados que los pueden comprometer gravemente. Por otro lado, la erradicación se enfrenta con la pertinaz resistencia de los mosquitos a los insecticidas, lo mismo que la capacidad que desarrollan los plasmodios de resistir las drogas antiparasitarias y de evadir el ataque del sistema inmune.

Hacia fines de la década de 1960, el gobierno chino puso en marcha un programa para hacer frente a la malaria, que cobraba más vidas en Vietnam que la guerra con los Estados Unidos. Como parte de ese programa Youyou Tu, consultando tratados médicos de hace 1600 años, ensayó extractos vegetales de más de 380 plantas en animales afectados de paludismo. Del ajenjo chino (Artemisia annua) aisló un compuesto, llamado artemisinina, que inhibía el desarrollo del plasmodio en el humano. Incluso experimentó la inocuidad de la droga en su propio cuerpo. Recién en 1979 se publicó en inglés la primera información sobre la droga pero, como era entonces habitual en China, sin dar el nombre de quien la había descubierto, por lo que la investigadora debió aguardar décadas para ser reconocida por la comunidad académica internacional. En la actualidad el tratamiento con artemisinina reduce en 30% la mortalidad infantil y hasta en 20% la de adultos, lo que significa más de cien mil vidas salvadas anualmente en regiones de alto endemismo de malaria.

Otra parasitosis humana transmitida por picaduras de insectos hematófagos, en este caso jejenes, es la oncocercosis u oncocerciasis, provocada por un nematodo o gusano redondo de la especie Onchocerca volvulus. Los gusanos adultos viven en el tejido subcutáneo y producen diversos trastornos como fibrosis, hiperqueratosis (engrosamiento de la piel), atrofia, alteraciones en la pigmentación y nódulos llamados oncocercomas. Las hembras fecundadas del gusano depositan en la circulación miles de larvas denominadas microfilarias que se distribuyen por todo el cuerpo aunque tienen tendencia a afectar la cámara anterior del ojo y producir daño irreversible en la membrana coroides. De ahí el nombre vulgar de la enfermedad –ceguera de los ríos–, pues en esos ambientes el ataque de los jejenes o mosquitas negras es más frecuente.

Los jejenes pican a una persona parasitada y succionan larvas del nematodo, que cumplen parte de su ciclo de vida en el insecto y se acumulan en sus glándulas salivales listas para ser inoculadas en otro ser humano cuando el jején se alimente de su sangre. Se calcula que hay en la actualidad más de cincuenta millones de enfermos en el mundo, en particular en África y en la Amazonia, con más de medio millón de ciegos. Merced a eficaces políticas sanitarias, la oncocercosis ha sido erradicada en varios países, como Guatemala (2013), Ecuador (2014) y México (2015), pero las malas condiciones sanitarias, socioeconómicas y culturales que persisten en algunos pueblos, sumadas a la resistencia a los insecticidas desarrollada por los jejenes y a los fármacos antiparasitarios por las filarias, son importantes factores de expansión de la enfermedad.

La filariosis linfática es otra de las enfermedades producidas por nematodos, principalmente de las especies Wuchereria bancrofti y Brugia malayi. Afecta a más de 120 millones de personas en el mundo y provoca severa incapacidad y postración en más de 40 millones. Los gusanos adultos suelen alcanzar una longitud de más de 10cm y tener 1mm de grosor. Se enroscan y encapsulan en nódulos, ganglios y vasos linfáticos de los seres humanos y producen millones de pequeñas microfilarias que viajan por el torrente circulatorio y son succionadas por mosquitos de los géneros Culex, Anopheles y Aedes cada vez que pican para alimentarse de sangre humana. De esta forma los insectos contagian a la población de extensas zonas tropicales del planeta.

Cuando los nematodos adultos mueren en los nódulos y vasos linfáticos humanos, se produce un enorme incremento del tamaño de los órganos afectados, en particular los miembros inferiores, la región inguinal, el escroto y las glándulas mamarias, que ha dado el nombre de elefantiasis a la enfermedad. Su erradicación también se ve obstaculizada por el creciente desarrollo de resistencia a los insecticidas por los mosquitos así como a las drogas antiparasitarias por parte de los nematodos.

Según la información oficial del premio Nobel, Campbell y Omura descubrieron una nueva droga, la avermectina cuyos derivados disminuyeron la incidencia de la ceguera de los ríos y de la filariosis linfática, además de ser eficaz contra un número creciente de otras enfermedades parasíticas. El principio activo antiparasitario de la droga, de baja toxicidad para los mamíferos pero con efectos letales para muchas especies de parásitos, entre ellos las microfilarias, se llama ivermectina, y es también eficaz contra parásitos que afectan a animales domésticos y causan millonarios perjuicios económicos a la producción agropecuaria. La droga es un producto natural, pues resulta de la acción de una bacteria que vive en el suelo llamada Streptomyces avermitilis.

ECONOMÍA

Consumo, pobreza y bienestar

El premio del Banco de Suecia en ciencias económicas en memoria de Alfred Nobel fue otorgado este año al economista británico-estadounidense Angus Deaton, de la Universidad de Princeton, por sus contribuciones al análisis del consumo, la pobreza y el bienestar. El premiado fue un pionero en estas tres grandes áreas de la economía, con aportes que no solo resultaron relevantes en el ámbito académico sino, también, en la forma en que se conciben hoy las políticas de desarrollo.

El eje central de sus investigaciones fue el comportamiento de los consumidores, cuyo estudio encaró con marcado énfasis en contrastar los marcos conceptuales con datos empíricos de la realidad. Los economistas recurren a dos grandes enfoques teóricos para analizar las elecciones de consumo.

Uno considera las decisiones que toma cada individuo de asignar en un momento dado el ingreso del que dispone a la compra de los distintos bienes que puede adquirir; el otro analiza las decisiones intertemporales de consumo, es decir, toma en cuenta que las personas también ahorran y evalúan, en consecuencia, si les conviene postergar o adelantar determinados consumos. Deaton innovó en ambos enfoques, y los aplicó en forma concreta al análisis del desarrollo humano.

Sistemas de demanda

Se conoce como sistema de demanda al conjunto de decisiones que toma un agente racional para elegir una canasta de consumo en función de los precios de cada bien y de su ingreso; en otras palabras, cómo cada individuo sustituye o complementa bienes de consumo de acuerdo con

sus preferencias y sus posibilidades económicas. Las primeras investigaciones de Deaton consideraron la validez de los axiomas sobre los que se apoyaba el análisis de los sistemas de demanda y llevaron a una expansión de ese análisis.

Conocer dichos sistemas es una herramienta fundamental no solo para verificar la validez de la teoría a la luz de los datos de la realidad sino, también, para definir de manera adecuada medidas de gobierno y políticas públicas. Por ejemplo, saber cómo reaccionan los consumidores ante variaciones de cada precio es un dato relevante para establecer impuestos y subsidios al consumo con el propósito de cambiar los precios de mercado, cuyo equilibrio en ausencia de esa acción puede llevar a una asignación ineficiente de los recursos de la economía.

Hacia 1980, Deaton desarrolló un método simple y flexible para estimar demandas en función de precios e ingresos individuales. Se lo conoce como Almost Ideal Demand System, y fue un avance no menor en materia de cuantificar el comportamiento de los consumidores. Con sus posteriores modificaciones es aún una herramienta estándar utilizada tanto en trabajos académicos como en informes técnicos sobre evaluaciones de políticas públicas y sus consecuencias sobre el consumo.

Ahorro, consumo y macroeconomía

Cuánto de su ingreso destinan los hogares al consumo y cuánto al ahorro es una cuestión de la que se ocupó la macroeconomía desde sus orígenes. Los principales avances en esa línea de investigación se deben a otros dos economistas galardonados con el Nobel: Milton Friedman (1912-2006), que lo obtuvo en 1975 por su hipótesis del ingreso permanente, y Franco Modigliani (1918-2003), ganador en 1985 por su modelo del ciclo de vida. Ambas teorías consideran el hecho de que el ahorro es la herramienta que permite a los hogares mantener el consumo relativamente estable a lo largo del tiempo, para evitar cambios bruscos en sus niveles de bienestar. De esta manera explicaron una constatación empírica de la macroeconomía: que el ingreso corriente tiene mayores variaciones en el tiempo que el consumo.

En trabajos que datan de alrededor de 1990, Deaton demostró que estas teorías, basadas en un agente representativo, podían llevar a ciertas contradicciones que no se advertían en la evidencia empírica. En particular, aun en el marco de la hipótesis del ingreso permanente era posible que el consumo excediese al ingreso corriente, algo que no era avalado por la regularidad de los datos empíricos macroeconómicos. Esto se conoció como la paradoja de Deaton. El foco central de su análisis fue que, tomándolos como agregados macroeconómicos, consumo e ingreso se comportan de manera que no se puede explicar como simple suma de las decisiones individuales. Ello se debe a que la heterogeneidad de las personas en cuanto a preferencias y restricciones de liquidez hace de la agregación un proceso extremadamente complicado. Deaton demostró que el análisis individual de los comportamientos de consumo es fundamental para entender la dinámica de los agregados.

Bienestar y pobreza

En décadas más recientes, su investigación se centró en cómo mejorar la medición de la pobreza y del bienestar, así como en analizar los factores determinantes de ambos. Notó que el consumo es una medida mucho más adecuada del bienestar de las personas que su ingreso, sobre todo en los países en desarrollo, en los que la variabilidad de los ingresos dificulta medir la pobreza de los hogares. Sobre la base de los avances que había realizado en materia de teoría del consumo, ideó formas de tomar como fuente fundamental de información los relevamientos de datos sobre comportamientos individuales.

Su libro The Analysis of Household Surveys es hoy lectura obligada en cualquier curso sobre desarrollo, desigualdad y pobreza. Abarca toda la serie de problemas que enfrenta un analista para medir la pobreza de una forma que permita no solo la comparación internacional sino, también, la comparación en el tiempo. Sus aportes metodológicos ayudan a resolver problemas prácticos de manera simple, pero basada en sólida teoría económica. Algunos ejemplos son sus análisis sobre las escalas de equivalencia entre distintos miembros de un hogar, la construcción adecuada de un índice de precios que permita comparaciones homogéneas en las estadísticas de pobreza y el uso de seudopaneles (un método que permite acoplar encuestas que no realizan seguimientos de los hogares en el tiempo) para estudiar la dinámica de fenómenos asociados con la pobreza en países en desarrollo.

Es posible destacar tres líneas fundamentales en los múltiples temas abordados por Deaton en esta etapa de su producción: la relación entre ingresos y nutrición, las trampas de la pobreza (es decir, el círculo vicioso alimentado por desnutrición y baja productividad laboral) y la discriminación de género en el hogar. Las dos primeras permiten entender las consecuencias de la desnutrición sobre la dinámica de los ingresos de los hogares y la efectividad de las políticas de ingresos para mejorar la nutrición familiar. La tercera línea intenta establecer si la forma en que los padres asignan los recursos del hogar es injusta por dar prioridad a los hijos varones.

Angus Deaton procuró acercar la teoría económica más abstracta a los datos de la realidad. El mayor acceso actual a todo tipo información hace que la investigación económica, tanto académica como dirigida a la acción, requiera en forma obligada fundamentar sus enfoques teóricos en datos empíricos. En esto, Deaton fue un gran pionero cuyas investigaciones ayudaron a transformar campos fundamentales de la microeconomía, la macroeconomía y, sobre todo, del análisis del desarrollo humano.